.

Vs(T,E) = p(T,E)/p(TvE).

.

Como indicaba al final, esta fórmula (que, además, se puede modificar para tener en cuenta el carácter aproximado de E, y el hecho de que está constituída por numerosas regularidades empíricas independientes entre sí) posee propiedades de lo más interesante. Pero antes de enumerarlas, indiquemos cuál es el objetivo principal de tener una definición como ésta: se trata de tener una reconstrucción matemática de los criterios comparativos que nos permiten decir si una teoría nos parece mejor que otra, o si una teoría nos parece en cierto momento mejor o peor que lo que nos parecía antes..

Bueno, pues vamos con las propiedades. En la próxima (y supongo que última, o penúltima) entrada, comentaré algunas implicaciones más "filosóficas" que también creo que son interesantes.

.

1) La probabilidad de una tautología es siempre igual a 1 (pues p(Taut, E) y P(Taut v E) siempre son 1, sea cual sea E). Nótese que 1 es un valor "bajo", pues Vs puede tener cualquier valor positivo.

.

2) Si los datos E confirman T, entonces Vs(T,E) = 1/p(T). Esto no suele ser una situación habitual: lo corriente es que busquemos teorías que expliquen los datos, y por lo tanto, una teoría T tales que E se siga de ella, no que T se siga de E. Pero podemos considerar que esto se aplica a cada una de las leyes empíricas cuya conjunción es E; lo que nos dice este resultado es que esas leyes serán tanto más valiosas científicamente cuanto menor sea su probabilidad a priori, es decir, cuanto más inesperadas sean.

.

.

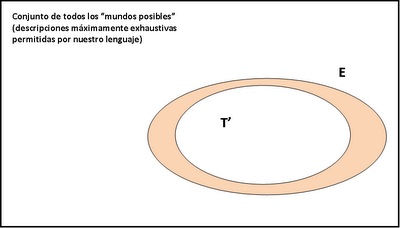

3) Si T explica E (es decir, si E se sigue de T), entonces Vs(T,E) = p(T)/p(E)^2. De aquí se sigue, en primer lugar, que, de dos teorías que consigan explicar E, la que nos parecerá más verosímil es la que es menos implausible a priori. En segundo lugar (o, lo que viene a ser lo mismo), la verosimilitud de una teoría que explica los hechos empíricos es inversamente proporcional a la probabilidad de que E sea verdad y T sea falsa (o sea, p(E&¬T): el área anaranjada en la imagen), o sea, si T está "dentro" de E, entonces cuanto más "espacio" ocupe dentro de E, más verosímil nos parecerá; o sea: cuanto menos espacio quede para teorías que sean incompatibles con E pero que también expliquen E, más verosímil nos parecerá T. Esto puede entenderse como una reconstrucción de la idea de David Deutsch de que las buenas explicaciones son las que resultan "difíciles de variar", pero entendiendo por "variar" la probabilidad de que HAYA algunas otras teorías T' que también expliquen E (probabilidad que es igual al área anaranjada), y no la probabilidad de que NOSOTROS ENCONTREMOS alguna de esas teorías (probabilidad que dependerá de otros factores, no sólo de cómo es el mundo o de cómo nos parece que es). Deutsch creo que confunde ambos sentidos, y eso hace de su explicación del asunto una explicación poco explicativa.

.

Por cierto, este resultado también implica que, para que una teoría T que explica los hechos empíricos E sea mejor que una "explicación tautológica" (cuya verosimilitud, recordemos, era igual a 1), entonces debe cumplirse que p(T,E) > p(E), lo que parece un requisito razonable (es decir, visto al revés, si la probabilidad de que T sea verdadera bajo el supuesto de que E es verdadero, es incluso menor que la probabilidad a priori de que E sea verdadero, entonces es que T es condenadamente mala: es incluso peor que no decir nada).

.

4) Si se confirma una nueva predicción F de la teoría T (es decir, una no incluida en aquellas cuya conjunción es E), entonces su verosimilitud aumenta, es decir, Vs(T,E) < Vs(T,E&F). Esto se cumple tanto si entendemos la "predicción" en el sentido de que T implica F, como en el sentido de que T únicamente implica que, si E es verdad, también es verdad F, como en el sentido de que p(F,T&E) > p(F,T).

.

Una de las propiedades más chorra y que a mí más me gusta es la siguiente:

.

5) Vs(T,E) es siempre menor o igual que 1/p(T) y que 1/p(E). Esta propiedad es importante porque para cada teoría posible, siempre hay un límite a la verosimilitud que puede alcanzar, y para conjunto de datos empíricos, siempre hay un límite a la verosimilitud que pueden conceder a cualquier teoría. Es decir, la ciencia siempre nos presentará situaciones en que lo único que podremos hacer para tener teorías aún más verosímiles que las que tenemos es, o bien inventar teorías cuya plausibilidad a priori sea más baja que la de las teorías anteriores, o bien encontrar nuevos datos empíricos, y generalmente ambas cosas. Esto hace honor a la idea popperiana de que la ciencia es una "búsqueda sin término". Y por otro lado, también nos muestra que la plausibilidad a priori de las teorías (lo "razonables" que nos parezcan, con independencia de los datos empíricos) es un arma de doble filo: según el punto 3 no puede ser muy baja, pero según el punto 5, habrá veces en que tengamos que inventar teorías muy implausibles. ¿Quién dijo que hacer buena ciencia tuviera que ser fácil?

.

6) El valor esperado de la funcion Vs(T,E) es igual a la "razón de probabilidad", p(T,E)/p(T), que a su vez es igual a la "razón de likelihood", p(E,T)/p(E). (Lo siento, pero la prueba de este teorema es un poco larga, y los que tengáis curiosidad la podréis ver en el libro Mentiras a medias, o en este artículo, (pgs., 356-357)). La noción matemática de "valor esperado" es aquí la misma que en el caso de Niiniluoto que vimos en la entrada tercera: cuál es el valor de Vs que esperaríamos en función de la probabilidad que E asigna a cada uno de los mundos posibles que son compatibles con E. Lo que significa este teorema es que la percepción de la verosimilitud de una teoría no es la misma cuando los científicos esperan que haya cambios importantes en E que cuando no lo esperan; en el primer caso, tenderán a considerar más razonable el valor esperado de Vs, mientras que en el segundo, tomarán E como (relativamente) "definitivo", y juzgarán las teorías directamente a través de Vs, no de su valor esperado. El caso es que las "razones" de probabilidad o likelihood son herramientas estadísticas habituales para la comparación de teorías, y el hecho de que nuestro modelo implique que eso ha de ser así es un punto a su favor.

.

7) Puede ocurrir que una teoría T' explique más hechos que otra T, pero parezca menos verosímil que ella. Este resultado tiene en cuenta la versión "c" del sentido de "aproximación" que indicamos en la entrada anterior: considerar la verosimilitud de una teoría como función de su coherencia con algún subconjunto de los hechos conocidos, no necesariamente todos. Esto ocurrirá, naturalmente, si T' explica más hechos Ei que T, pero la plausibilidad a priori de T' es mucho menor que la de T. Esto algo que suele ocurrir en las "revoluciones científicas" según Kuhn: el paradigma "nuevo" tiene menos anomalías que el "viejo", pero los defensores del viejo siguen defendiendo éste porque el paradigma nuevo les parece que hace supuestos intolerablemente implausibles.

.

Esto puede entenderse como una reconstrucción de la idea de David Deutsch de que las buenas explicaciones son las que resultan "difíciles de variar", pero entendiendo por "variar" la probabilidad de que HAYA algunas otras teorías T' que también expliquen E

ResponderEliminarPues entonces tenemos un problema, porque esa probabilidad es siempre 1, la certeza absoluta: para cualquier conjunto de datos que se nos ocurra, habrá siempre infinitas teorías posibles capaces de explicarlos.

EI

Eliminarentendiendo por "variar" la probabilidad de que HAYA algunas otras teorías T' que también expliquen E

Pues entonces tenemos un problema, porque esa probabilidad es siempre 1

Perdón, lo he expresado mal: la probabilidad a la que me refiero es la correspondiente al área en naranja, que no es la probabilidad de que "haya alguna teoría" que sea incompatible con T pero que explique E, sino la probabilidad de que "alguna teoría que sea incompatible con T pero que explique E SEA VERDADERA".

Técnicamente, es la probabilidad SUBJETIVA (pues esas áreas siempre las interpreto como probabilidades subjetivas) de la proposición E&¬T.

Hago el comentario con la prudencia de quien sabe que no ha entendido ni la décima parte de esa ensalada de fórmulas de ahí arriba.

ResponderEliminar“Esto puede entenderse como una reconstrucción de la idea de David Deutsch de que las buenas explicaciones son las que resultan "difíciles de variar", pero entendiendo por "variar" la probabilidad de que HAYA algunas otras teorías T' que también expliquen E (probabilidad que es igual al área anaranjada), y no la probabilidad de que NOSOTROS ENCONTREMOS alguna de esas teorías (probabilidad que dependerá de otros factores, no sólo de cómo es el mundo o de cómo nos parece que es). Deutsch creo que confunde ambos sentidos, y eso hace de su explicación del asunto una explicación poco explicativa”.

ResponderEliminar¿Y qué más da que sea Popper, Deutsch o cualquiera de nosotros los que hallemos una teoría T que también explique E? Al fin y al cabo será una teoría aproximada a cómo el mundo es. Te atrincheras en el “mundo qué es” como un ente irreductible, ¿entonces para qué elaborar enunciados acerca del mismo? El mundo es lo qué es, y los muchos mundos son lo qué son, pero resulta que el mundo o los muchos mundos y las teorías que lo/los explica/an se construye/en por observadores que son una parte del mundo y por tanto hay un sesgo subjetivo y/o verosímil tan irreductible como el mismo mundo. Las buena teorías, no es que puedan ser variadas/mejoradas (o empeoradas), sino que son verosímiles o inverosímiles respecto del mundo que describen. Me pregunto si confundes una teoría consistente con el instrumento, en este caso tu cadena de funciones y fórmulas. El instrumento es eso, una herramienta, pero no debemos perder de vista qué pretendemos medir y teorizar sin confundir la teoría con el instrumento.

No entiendo lo que me criticas, Anónimo. ¿Podrías explicarlo un poco más claramente?

EliminarJesús,

ResponderEliminarVale. Entonces tú estás diciendo que la cercanía a la verdad de una teoría es igual a su probabilidad de ser cierta (o, lo que es igual: a la probabilidad de que no sea cierta otra).

Yo no veo que esto suponga una reconstrucción del concepto deutschiano de variabilidad, que va por otro lado, y además me plantea dos dudas:

- ¿Cómo se calcula esa probabilidad?

- ¿Están igualmente alejadas de la verdad todas las teorías refutadas, puesto que su probabilidad de tener alternativas verdaderas incompatibles con ellas es absoluta?

EI

ResponderEliminarEntonces tú estás diciendo que la cercanía a la verdad de una teoría es igual a su probabilidad de ser cierta

¡¡¡¡BUAAAAA!!!! ¿¿¿Cómo puedes pensar que lo que "estoy diciendo" es que la cercanía a la verdad es IGUAL a su probabilidad??? Al contrario: lo que hago es tomar las funciones de probabilidad, p(T), p(T,E), p(T,TvE), p(E), etc., y construir con ellas una función DISTINTA, que es Vs=p(T,E)/p(TvE), que considero que es nuestra mejor reconstrucción de la "idea intuitiva" de "aproximación a la verdad". Pero obviamente la función Vs no es "igual" a ninguna probabilidad, porque no tiene las propiedades matemáticas de una función de probabilidad.

.

Lo que ocurre es que la función Vs, en el CASO de aquellas teorías que explican los hechos conocidos (E), es PROPORCIONAL a la función de probabilidad a posteriori (pues en este caso, Vs(T,E) = p(T)/[p(E)^2]), o sea, de dos teorías tales que AMBAS expliquen todos los hechos conocidos, nos parecerá más verosímil exactamente aquella que nos parezca más probable, tanto a priori como a posteriori. Esto implica, por ejemplo, que una teoría que explique E, pero cuya probabilidad a priori sea para nosotros, por las razones que sea, ridículamente improbable, pues nos parecerá también ridículamente INverosímil (en mi sentido, o sea, nos parecerá extremadamente alejada de la verdad).

Eso no quiere decir que una teoría ridículamente improbable no pueda LLEGAR a tener una verosimilitud la hostia de alta: lo que ocurre es que necesitamos en este caso que p(T,E) sea mucho más elevada que p(E), lo que parece razonable: necesitamos que la teoría explique o prediga descubrimientos empíricos que nos parezcan A PRIORI (o sea, antes de descubrirlos) la hostia de improbables.

.

Yo no veo que esto suponga una reconstrucción del concepto deutschiano de variabilidad

Pues a mí me parece bastante claro: una teoría exitosa (o sea, que explica E) "fácil de variar" sería una teoría tal que p(T,E) es muy pequeño, o sea, p(¬T,E) es muy alto: juzgamos que, aunque E explique T, es muy probable que T no sea verdad, o sea, que HAYA alguna otra teoría T' que sea VERDADERA, que sea contradictoria con T, pero que también explique E, aunque no tengamos ni pajolera idea de cómo DESCUBRIR esa teoría.

.

¿Cómo se calcula esa probabilidad?

En general, de ninguna manera. Mi enfoque es bayesiano, es decir, parte del supuesto de que TODA determinación (a posteriori) de alguna función de probabilidad parte de la existencia de algunas estimaciones de probabilidad que el sujeto toma como dadas, que le parecen intuitivas, que no tiene ni idea de dónde vienen, pero que no puede dejar de aceptar, es decir, toma como dadas estimaciones de probabilidad A PRIORI. Lo que hace el bayesianismo es poner ciertas condiciones a esas funciones a priori de tal modo que puedan utilizarse como probabilidades a posteriori; lo que añade mi teoría es que con esas funciones de probabilidad se pueden definir otras funciones QUE NO SON DE PROBABILIDAD, sino de "apariencia subjetiva de proximidad a la verdad", o sea, verosimilitud.

.

¿Están igualmente alejadas de la verdad todas las teorías refutadas

Depende: con la función Vs(T,E) = p(T,E)/p(TvE), SÍ. Pero cuando se tienen en cuenta los factores b y c que indicaba en la entrada anterior (grados de precisión, y estructura interna de E), entonces es posible que dos teorías refutadas (o sea, tales que E implica ¬T) tengan grados de verosimilitud distintos de cero y distintos entre sí.

Jesús,

ResponderEliminar¿¿¿Cómo puedes pensar que lo que "estoy diciendo" es que la cercanía a la verdad es IGUAL a su probabilidad???

Hostias, perdona: quería decir "proporcional", claro.

juzgamos que... es muy probable que T no sea verdad, o sea, que HAYA alguna otra teoría T'... aunque no tengamos ni pajolera idea de cómo DESCUBRIR esa teoría.

Por eso digo que tu propuesta no "reconstruye" la deutschiana. Deutsch entiende que no tenemos ninguna forma de calcular la probabilidad de que una teoría sea falsa, y que pretender lo contrario son ganas de hacerse trampas en el solitario (perdón por el latiguillo periodístico) y de querer presentar como razones nuestras corazonadas. De hecho, el concepto de probabilidad (y su prima la credibilidad) no tiene demasiada importancia en el sistema deutschiano, donde lo fundamental son -como ya discutimos- las justificaciones.

¿Cómo se calcula esa probabilidad?

En general, de ninguna manera.

Entonces no parece que ganemos demasiado en rigor sino, a lo sumo, en una apariencia de rigor. El centro de la cuestión sigue estando en el valor subjetivo que los expertos en una materia conceden a ciertas teorías y argumentos.

Y ahí está, creo, la confusión principal. Lo racional es apostar por aquellos resultados que son más probables. En el enfoque bayesiano, sin embargo, ponemos el carro delante de los bueyes y decidimos que lo racional es considerar más probable aquello por lo que estaríamos dispuestos a apostar.

cuando se tienen en cuenta los factores b y c que indicaba en la entrada anterior (grados de precisión, y estructura interna de E), entonces es posible que dos teorías refutadas (o sea, tales que E implica ¬T) tengan grados de verosimilitud distintos de cero y distintos entre sí.

Cuando dices que "es posible", ¿es una forma de hablar o quieres decir que no sabes con certeza si es así? (No es una pregunta retórica, realmente no lo entiendo. Todo esto es muy complicado para mí y debo de estar miccionando en la periferia del macetero).

Discrepancias aparte, tu propuesta me parece muy potente (hasta donde soy capaz de comprenderla) y la mayor parte de las consecuencias que enumeras aquí me parecen acertadas y fecundas. Que se siga de tu fórmula el hecho de que los resultados inesperados tienen un valor especial en ciencia, por ejemplo, me parece espectacular.

ResponderEliminarCreo que no pararé por aquí hasta el lunes. Un saludo.

Mil gracias, EI.

ResponderEliminarCon respecto al tema de la probabilidad subjetiva, es cierto que en el fondo se trata de "corazonadas", o más bien, de que cualquier cálculo de probabilidades se basa en dos cosas: la interacción entre algunos datos y algunas corazonadas, los datos solos no permiten inferir ninguna probabilidad, y las corazonadas solas tampoco sirven para mucho. Deutsch piensa que podemos prescindir de la parte de "animal spirit" que son las "corazonadas", pero yo pienso que no, que sin ellas sencillamente no podemos "arrancar" el proceso de razonamiento empírico, es decir, el proceso de extraer información sobre lo desconocido a partir de la información conocida. Digamos que la probabilidad subjetiva es a nuestro pensamiento como las enzimas son a nuestros alimentos: por mucho que comamos, sin ellas no podemos asimilar los nutrientes, y por mucha información que metamos en nuestros argumentos, sin alguna "intuición animal" que nos permita traducir esa información en términos de "probable o improbable", tampoco nos sirve para nada esa información;naturalmente, esas intuiciones pueden estar muy erradas, pero es el resultado de la contrastación de las predicciones que hacemos gracias a ellas lo que nos permite corregirlas.

En concreto, si tenemos una teoría T que explica E (los hechos conocidos), pero nuestra "corazonada" no nos dice NADA sobre lo probable que es que T sea verdad (o sea, si no tenemos NINGUNA intuición sobre si p(T,E) es alto o bajo), entonces no podemos tener NINGUNA respuesta a la pregunta siguiente: "¿cómo de probable es que sea verdad la predicción F, que se sigue de T, pero que no se sigue de E?".

En cambio, si nuestras intuiciones dicen que p(T,E) es alto, tendremos bastante confianza en que F se cumplirá, mientras que si p(T,E) es muy bajo (recuerda que T implica E, pero aun así, puede que p(¬T,E) sea muchísimo mayor que p(T,E), entonces pensaremos que lo más probable es que F sea falso. Naturalmkente, DESPUÉS de observado si se cumple F o no, si vemos que se cumple tendremos que p(T,E&F) es mayor que p(T,E), y por lo tanto, Vs(T,E&F) será también mayor que Vs(T,E).

Sigo: lo de "es posible" quiere decir simplemente que habrá casos en que Vs(T,E) es alto y casos en que Vs(T',E) sea bajo, aunque tanto T como T' estén refutados por E.

ResponderEliminarBien, confirmo mi grata impresión plasmada en el comentario a la entrada anterior porque soy de la opinión de que las corazonadas o probabilidades subjetivas no son más, -ni menos- que barruntos científicos realizados desde el conocimiento experimental y teórico adquirido.

ResponderEliminarJesús:

ResponderEliminarEs muy estimable tu intento de ligar la verosimilitud de una teoría a lo improbable que sea a priori y a lo probable que sea que los datos sean verdaderos.

Lo que no acabo de ver es qué progreso hay en esto con referencia a la inferencia bayesiana y de qué manera escapas a la crítica de Tichy -lo sé, me repito, pero no me convenciste la vez anterior- a la hora de contar casos favorables o no favorables mejor que Popper o que los científicos experimentales antes de tu artículo y entradas.

Siempre se enseña la probabilidad condicional y las falacias del falso positivo. Creo que un filósofo puede y debe explicar cómo es que los científicos progresan haciendo lo que hacen, pero me da la impresión de que ya estaba explicado.

Sursum:

EliminarEs muy estimable tu intento de ligar la verosimilitud de una teoría a lo improbable que sea a priori y a lo probable que sea que los datos sean verdaderos

Gracias. Pero permíteme que señale que es justo al revés: una teoría T que explique los datos empíricos E será tanto más verosímil cuanto más PROBABLE A PRIORI (y en este caso, también a posteriori) sea T, y cuanto más IMPROBABLES A PRIORI sean los datos E. Es decir, una buena teoría tiene que combinar dos virtudes que generalmente van en sentido contrario (y por eso es tan difícil dar con ellas): sus postulados tienen que parecernos lo más "plausibles", "lógicos", "razonables".... que sea posible, pero tiene que generar predicciones lo más "sorprendentes", "implausibles" e "inesperadas" que sea posible.

.

Lo que no acabo de ver es qué progreso hay en esto con referencia a la inferencia bayesiana

Pues muy sencillo:

1º) Esto no va "en contra" de la inferencia bayesiana, sino que la presupone; la inferencia bayesiana sirve para estimar los valores de las funciones que entran en la definición de Vs.

2º) Pero va MÁS ALLÁ de la inferencia bayesiana: la función de probabilidad bayesiana SÓLO nos dice cómo de probable es que cierto enunciado, hipótesis, teoría, etc., sea verdadero, en función de la evidencia empírica que tenemos, pero no nos dice por qué, si ya tenemos algunos enunciados cuya probabilidad es igual a 1 (o prácticamente igual a 1), tendremos que buscar OTROS. En particular, si ya tenemos E (los hechos empíricos conocidos en un momento dado, cuya probabilidad es 1 o prácticamente 1, pues en eso consiste en que los demos por "conocidos"), ¿para qué tenemos que esforzarnos en buscar MÁS hechos empíricos? El bayesianismo dice cómo ajustar nuestras creencias sobre la probabilidad de las hipótesis en función de la evidencia empírica, pero no nos da ninguna razón por la cual sea necesario ACUMULAR más evidencia empírica. En cambio mi propuesta sí que permite explicar por qué la ciencia es una "búsqueda sin término": es lo que dice el punto 5.

.

sigo

sigo

Eliminarde qué manera escapas a la crítica de Tichy

Muy sencillo: escapo de la crítica de Tichy, no de alguna iNTERPRETACIÓN de lo que la crítica de Tichy "significa"; y escapo simplemente porque mi definición de verosimilitud es formalmente distinta de la de Popper, y no hay manera de APLICARLE la crítica de Tichy. Recuerda que esta crítica decía LITERALMENTE lo siguiente: si A es una teoría falsa, y A tiene todas las consecuencias verdaderas que tiene otra teoría B, entonces habrá algún enunciado falso X que se seguirá de A y no se seguirá de B, y por lo tanto, no puede cumplirse una de las cláusulas de la definición de verosimilitud de Popper para que A sea más verosímil que B (o sea, la cláusula de que B tenga todas las consecuencias falsas de A). Es IRRELEVANTE qué enunciados utiliza la prueba de Tichy para demostrar eso, pues ESO es lo único importante: dos teorías falsas A y B no pueden estar en la relación "A es más verosímil que B" según la definición popperiana de "ser más verosímil que". Como mi definición de verosimilitud NO SE BASA en qué consecuencias se siguen de A y de B, no hay manera de aplicar esta crítica a mi definición; de hecho, es trivial mostrar que es lógicamente posible que haya dos teorías falsas A y B tales que una de ellas sea más verosímil que la otra (supón que A implica B, B implica E, y B es falsa -es decir, que el mundo verdadero es uno de los mundos incluidos en E pero no en B -ni por lo tanto en A-).

.

Creo que un filósofo puede y debe explicar cómo es que los científicos progresan haciendo lo que hacen

En efecto, a eso me dedico yo.

Jesús:

Eliminar"Gracias. Pero permíteme que señale que es justo al revés: una teoría T que explique los datos empíricos E será tanto más verosímil cuanto más PROBABLE A PRIORI (y en este caso, también a posteriori) sea T, y cuanto más IMPROBABLES A PRIORI sean los datos E."

De nada.

Una teoría, como enunciado o conjunto de enunciados, no tiene una probabilidad determinada, salvo que la probabilidad de dos enunciados vistos como lógicamente independientes tiene que ser menor o igual que la de cualquiera de ellos. Pero ¿cómo medirías la probabilidad a priori de una hipótesis?

Lo que medimos es la probabilidad de que los enunciados que se siguen de la teoría sean verdaderos y en ese caso interesa que sean improbables a priori, que sean concretos y específicos y que no sean compatibles con un gran número de datos a priori. Es decir, que nos dé más información que un enunciado al azar.

Por otra parte, si predecimos un resultado con mucha precisión, es improbable al azar que la predicción sea confirmada. y la confirmación de la predicción corrobora la hipótesis en cuanto que demuestra que contiene más información que el azar.

"Es decir, una buena teoría tiene que combinar dos virtudes que generalmente van en sentido contrario (y por eso es tan difícil dar con ellas): sus postulados tienen que parecernos lo más "plausibles", "lógicos", "razonables".... que sea posible, pero tiene que generar predicciones lo más "sorprendentes", "implausibles" e "inesperadas" que sea posible."

Pero ser razonable no es ser probable. Sólo si nos referimos a su coherencia con teorías validadas por la experiencia con anterioridad, o con datos conocidos. La ciencia sólo progresa si las conjeturas razonables explican más datos que no hacerlas.

"pero no nos dice por qué, si ya tenemos algunos enunciados cuya probabilidad es igual a 1 (o prácticamente igual a 1), tendremos que buscar OTROS. En particular, si ya tenemos E (los hechos empíricos conocidos en un momento dado, cuya probabilidad es 1 o prácticamente 1, pues en eso consiste en que los demos por "conocidos"), ¿para qué tenemos que esforzarnos en buscar MÁS hechos empíricos?"

Porque podemos si tomamos los datos como aislados la probablidad de que sean verdaderos es 1 (teniendo en cuenta la precisión de las medidas, ese intervalo c al que te refieres), pero NO permiten decir nada más que contar y recontar los mismos hechos, sin que nada más quede explicado. Lo que buscamos es una teoría en la que esos datos no aparezcan como independientes sino liganods por una regularidad. Así, com una teoría y menos datos podemos resumir todo un conjunto infinito de datos presentes, pasados y futuros.

Un ejemplo. Sales de casa y anotas la matrícula de cada coche que ves. Puedes crear un polinomio tan complejo como necesites y que de el valor de la matrícula en función del ordinal de la observación. Pero eso NO te permite predecir con éxito las siguientes matrículas que observarás. O si lo haces, avisa.

"no nos da ninguna razón por la cual sea necesario ACUMULAR más evidencia empírica."

Porque de no hacerlo, podemos tener una ley que explique la caída de las manzanas, otra la de los copos de nieve, otra para la Luna... Eso equivale a decir que se trata de leyes independientes, Pero llega Newton y lo unifica en una sola ley.

Así, buscamos la ley que tenga como casos particulares otras leyes de rango menor y los datos de nuestras observaciones. Es una búsqueda sin término porque todo conjunto de leyes queda sin explicación hasta que las reducimos a un conjunto menor de leyes independientes, con algunas de ellas como consecuencia de unas pocas o de una, y las que queden sin explicación no son sino una etapa en esa búsqueda que nunca podemos dar por terminada porque nunca -lo has escrito también tú- tenemos la explicación de todo.

sigue ->

sigue ->

Eliminar"y escapo simplemente porque mi definición de verosimilitud es formalmente distinta de la de Popper, y no hay manera de APLICARLE la crítica de Tichy."

Sigues necesitando que los datos favorables y no favorables te permitan medir la probabilidad de acertar. Y Tichy tomaba como un dato desfavorable nuevo cada conjunción de uno desfavorable con otros favorables cualesquiera.

"...mi definición de verosimilitud NO SE BASA en qué consecuencias se siguen de A y de B,..."

¿Y cómo mides la probabilidad de que A sea verdadera sino porque de A se siguen a1 a2... an?

"En efecto, a eso me dedico yo."

Y por eso te leo. La filosofía no es un parloteo incesante acerca de temas raros con palabras oscuras sino una investigación acerca de cómo podemos conocer lo que conocemos. Es la ciencia que trata sobre las ciencias y sobre su método.

la probabilidad de LA CONJUNCION DE dos enunciados vistos como lógicamente independientes

EliminarEste comentario ha sido eliminado por el autor.

ResponderEliminarSursum:

ResponderEliminarUna teoría, como enunciado o conjunto de enunciados, no tiene una probabilidad determinada,

Según el bayesianismo, no es que las proposiciones "tengan" una probabilidad o la dejen de tener, sino que el GRADO DE CREENCIA de cada sujeto en la verdad de cada proposición se puede y debe representar mediante una función de probabilidad.

.

¿cómo medirías la probabilidad a priori de una hipótesis?

De ninguna manera: son meros juicios subjetivos, que dependerán de las intuiciones (o, como decía otro comentarista, "corazonadas") de cada sujeto. La misma proposición X puede tener una probabilidad (a priori o a posteriori) para un sujeto, y otra probabilidad distinta para otro. Lo único que se garantiza en el bayesianismo es que, cuando la cantidad de información que comparten dos sujetos tiende a infinito, sus probabilidades subjetivas tienden a igualarse.

Naturalmente, también está el principio conocido en inglés como "principal principle", que dice que si en algún caso existen probabilidades OBJETIVAS (p.ej., frecuencias empíricamente dadas), lo racional es ajustar las probabilidades subjetivas a estas.

.

si predecimos un resultado con mucha precisión, es improbable al azar que la predicción sea confirmada. y la confirmación de la predicción corrobora la hipótesis en cuanto que demuestra que contiene más información que el azar.

Eso es exactamente una de las intuiciones de las que mi modelo pretende dar cuenta.

.

ser razonable no es ser probable

Bueno, estoy refiriéndome con "razonable" a lo que los bayesianos considerarían que influye en la función de probabilidad subjetiva apriori de cada sujeto. No niego que habrá otros sentidos de "razonable".

.

Porque podemos si tomamos...

No te pregunto por qué dirías tú que necesitamos más y más datos; digo que en el bayesianismo no hay una explicación convincente de por qué los necesitamos, y mi modelo en cambio lo implica como una cuestión trivial.

.

sigo

sigo

ResponderEliminarbuscamos la ley que tenga como casos particulares otras leyes de rango menor

Por supuesto, pero insisto: el bayesianismo no explica por qué, y mi modelo sí: ¿por qué es mejor tener UNA teoría -es decir, un conjunto pequeño de hipótesis- que MUCHAS teorías lógicamente independientes entre sí -cada una de ellas con más o menos el mismo número de hipótesis que la primera teoría-, pero que permitan predecir los mismos hechos empíricos que aquélla? Pues porque la probabilidad a priori de la primera teoría, que está formada por menos hipótesis independientes, tenderá a ser mucho mayor que la probabilidad de la conjunción de todas esas teorías independientes.

.

Sigues necesitando que los datos favorables y no favorables te permitan medir la probabilidad de acertar

Pero eso es algo COMPLETAMENTE DIFERENTE de la demostración de Tichy. Y es una necesidad que se satisface directamente una vez que uno asume la existencia de grados de creencia subjetivos en las proposiciones, tales que satisfacen los axiomas de la teoría de la probabilidad.

.

Tichy tomaba como un dato desfavorable nuevo cada conjunción de uno desfavorable con otros favorables cualesquiera.

NO: Tichy ni tomaba ni dejaba de tomar nada de eso; lo suyo es una demostración LÓGICA, que es totalmente independiente de la INTERPRETACIÓN EPISTEMOLÓGICA que le queramos dar a los términos que aparecen en ella. El caso es que el teorema de Tichy muestra que la definición de Popper es inaplicable; esa es su única utilidad y relevancia. La única moraleja relevante del teorema de Tichy es que una definición apropiada de verosimilitud no debe permitir derivar ese teorema, y ése es el caso con mi definición.

.

¿Y cómo mides la probabilidad de que A sea verdadera sino porque de A se siguen a1 a2... an?

Insisto, eso es irrelevante para la cuestión de si el teorema de Tichy se aplica a mi definición o se deja de aplicar. Y además, como las funciones de probabilidad que estoy considerando son subjetivas, no hace falta "medirlas". Lo único que se exige es que sean coherentes con los axiomas de Kolmogorov (p.ej. que si T implica E y F, entonces p(T,E) sea menor o igual que p(T,E&F)).

.

Por supuesto, pero insisto: el bayesianismo no explica por qué, y mi modelo sí:

ResponderEliminarComo que el bayesianismo no explica esto?? La explicacion que dices da tu modelo no es mas que teoria de probabilidad pura y dura, P(A,B) <= P(B), que entra en cualquier calculos sobre priors.

El bayesianismo dice cómo ajustar nuestras creencias sobre la probabilidad de las hipótesis en función de la evidencia empírica, pero no nos da ninguna razón por la cual sea necesario ACUMULAR más evidencia empírica.

Como que no? La utilidad de hacer un experimento y acumular mas informacion se considera explicitamente en Bayesian experimental design. Ver

http://en.wikipedia.org/wiki/Kullback–Leibler_divergence

http://en.wikipedia.org/wiki/Bayesian_experimental_design#Gain_in_Shannon_information_as_utility

http://en.wikipedia.org/wiki/Gibbs%27_inequality

Sursum:

ResponderEliminarme alegro de que ya no preguntes de dónde salen los valores de la función p (o, al menos, de que hayas trasladado la pregunta a los autores de los artículos de la wikipedia).

Con respecto a lo que preguntas, fíjate que, en el modelo bayesiano que mencionas, una vez que hemos conseguido una hipótesis cuya probabilidad a posteriori dada la evidencia E es igual a 1, se ha acabado el juego: ya tenemos la máxima utilidad que podemos alcanzar. En cambio, en mi modelo, si tenemos una teoría T que explica los datos empíricos E y que además éstos confirman plenamente la teoría (o sea, p(T,E) = 1, y p(E,T) = 1), eso no implica que Vs haya alcanzado el máximo valor que puede alcanzar (en este caso, Vs(T,E) = 1/p(E) = 1/p(T)). Lo que implica mi modelo es que en ese caso, para aumentar la verosimilitud de nuestro conocimiento tendremos que buscar NUEVOS datos empíricos, y sobre todo, alguna hipótesis que explique los nuevos datos empíricos, porque, como en este caso T es equivalente a E, no podrá explicar los datos nuevos.

Es decir, el bayesianismo permite explicar lo que pasa en el "juego" de intentar confirmar una hipótesis, pero una vez que la hemos confirmado, no nos ofrece ninguna razón para continuar con el juego buscando hipótesis más fuertes. Naturalmente, esto se puede introducir ad hoc en el modelo bayesiano, pero eso: ad hoc.

Perdona, David, mi comentario anterior iba para ti; me equivoqué y creía que era de Sursum.

ResponderEliminarBueno, yo no preguntaba nada, simplemente objetaba a lo que decias en lo que te cite, que creo que no es asi.

ResponderEliminaruna vez que hemos conseguido una hipótesis cuya probabilidad a posteriori dada la evidencia E es igual a 1, se ha acabado el juego: ya tenemos la máxima utilidad que podemos alcanzar.

Tu error es representar el bayesianismo en terminos de confirmacion y refutacion absolutas, cuando _no es ese el caso_. Son grados de probabilidad que pueden tender a 1 o a 0, pero no lo alcanzan nunca. El bayesanismo tal cual ya incorpora de esta manera la "búsqueda sin término" sin ningun mecanismo ad-hoc.

David

ResponderEliminarPor un lado, la cuestión no es si los valores 0 y 1 se alcanzan o si sólo nos aproximamos a ellos: de hecho, hay muchos casos en los que los alcanzamos (al fin y al cabo, la información en la que basamos nuestras estimaciones de probabilidad a posteriori la tomamos como cierta, así como todo aquello que se deduzca lógicamente de esa información).

Por otro lado, lo que me parece ad hoc es que, en el bayesianismo, sólo hay una forma de conseguir el resultado que dice que, entre las hipótesis H y H', bajo el supuesto de que su probabilidad a posteriori es la misma, la mejor será la que tenga una probabilidad a priori más baja: a saber, la única forma de conseguir esto es meter "a capón" en la definición de la función U(y,X) (en el segundo enlace que me pones) el último factor, o sea -∫log(p(h))p(h)d(h) ). Ese factor se mete únicamente con el fin de conseguir eso que en mi modelo sale sin necesidad de "añadir" nada.

la información en la que basamos nuestras estimaciones de probabilidad a posteriori la tomamos como cierta, así como todo aquello que se deduzca lógicamente de esa información

ResponderEliminarLa cuestion si es esa. Las evidencias tiene caracter de ciertas, pero _las teorias en si_ no alcanzan el valor 1.

No hay mas que ver el denominador de Bayes para ver que la unica forma de que se alcanzara dicho valor requeriria tener la certeza de que _ninguna de la infinites posibles teorias alternativas (conocidas y desconocidas) podrian producir el mismo resultado, E.

De ahi la utilidad de acumular informacion adicional, que es lo que se mide conforme en el diseño bayesiano de experimentos, y la busqueda sin termino.

Por otro lado, lo que me parece ad hoc es que, en el bayesianismo, sólo hay una forma de conseguir el resultado que dice que, entre las hipótesis H y H', bajo el supuesto de que su probabilidad a posteriori es la misma, la mejor será la que tenga una probabilidad a priori más baja

Es que el bayesianismo no dice eso. Los enlaces que te pase tienen que ver con la utilidad de la informacion derivada de la observacion, no con distinguir entre teorias con el mismo posterior.

Si tu modelo habla de preferir entre teorias con los mismos posteriors, entonces ahi _si_ que dices algo que no dice el bayesianismo, pero no en lo de acumular informacion.

David

ResponderEliminara lo que me refiero es que el bayesianismo (es decir, la tesis de que las creencias de la gente se pueden representar como probabilidades subjetivas, que se actualizan según la regla de Bayes) no determina una función de "utilidad cognitiva" en particular; se puede usar la que citas en la wikipedia, pero también se pueden usar otras, como la que propongo yo, o las que han propuesto otros autores. Cuál sea la "correcta" creo que no es una cuestión que se pueda demostrar con razonamientos meramente matemáticos, sino que, igual que las funciones de utilidad de la teoría económica, serán... las que cada uno tenga: tal vez haya sujetos que valoren (cognitivamente hablando) más unas cosas, y otros que valoren otras. Mi tesis es que una función como la que propongo yo refleja mejor las preferencias cognitivas que los científicos REVELAN al seguir ciertas pautas metodológicas, pero naturalmente no pretendo haber "captado la verdad", sino sólo haber propuesto un modelo que puede ser más o menos aproximado a la verdad sobre el asunto.

En particular, como habrás podido ver, en realidad mi modelo permite dar una explicación del modelo bayesiano que indicas, como dice el resultado 6 de esta entrada, al menos en ciertos contextos: p(T,E)/p(T) es equivalente a log(p(T,E)) - logp(T).

también se pueden usar otras, como la que propongo yo, o las que han propuesto otros autores

ResponderEliminarEstoy de acuerdo. Esto me lleva a lo que dije en otro comentario, seria interesante probar como funciona cada una, y ver que equivalencias hay y porque existen. Si tengo tiempo voy a leerme tu pdf en mas detalle.

En particular, como habrás podido ver, en realidad mi modelo permite dar una explicación del modelo bayesiano que indicas, como dice el resultado 6 de esta entrada, al menos en ciertos contextos: p(T,E)/p(T) es equivalente a log(p(T,E)) - logp(T).

No se si me explicado bien sobre como se llega a las ecuaciones y por que tienen los terminos que tienen. El punto de partida es medir la desviacion del modelo asi:

Cuanta informacion voy a necesitar para describir el fenomeno partiendo de las predicciones de mi teoria?

Cuanta mas informacion necesite, o sea, cuanto mas se desvie mi teoria y me soprenda la realidad, mas informacion necesitare para describirlo. Cuanto mas correctas sean mis predicciones, menos informacion necesitare. Asi que, en efecto, estamos hablando de la entropia relativa, antes y despues de observar nuevas evidencias:

U = H(P, Q) - H(P)

Donde Q es la teoria anterior, y P es la teoria actualizada con las evidencias. Asi que partiendo de la teoria de la informacion y bayes se llega de manera natural a las expresiones que se citan en la entrada de la wikipedia, que no son mas que expansiones de lo que acabo de poner yo aqui.

David

ResponderEliminarsi que, en efecto, estamos hablando de la entropia relativa, antes y despues de observar nuevas evidencias:

U = H(P, Q) - H(P)

Donde Q es la teoria anterior, y P es la teoria actualizada con las evidencias

No es eso lo que ponía en el enlace: allí dice más bien la diferencia entre la probabilidad a posteriori (o sea, dadas las evidencas) de la teoría, y la probabilidad a priori (la que tiene sin considerar NINGUNA evidencia, ni siquiera "la anterior").

.

Cuanta informacion voy a necesitar para describir el fenomeno partiendo de las predicciones de mi teoria?

Cuanta mas informacion necesite, o sea, cuanto mas se desvie mi teoria...

Bueno, si tu teoría "se desvía", eso quiere decir que hace alguna predicción falsa, y por lo tanto su probabilidad a posteriori es 0, así que "para describir el fenómeno partiendo de las predicciones de la teoría" lo primero que haría falta sería tirar esa teoría a la basura y buscar otra cuyas predicciones fueran acertadas. No veo que haya tal cosa como "describir un fenómeno partiendo de ciertas predicciones": o bien las predicciones describen el fenómeno, o no lo describen.

.

No es eso lo que ponía en el enlace: allí dice más bien la diferencia entre la probabilidad a posteriori (o sea, dadas las evidencas) de la teoría, y la probabilidad a priori (la que tiene sin considerar NINGUNA evidencia, ni siquiera "la anterior").

ResponderEliminarPrimero, no es diferencia de probabilidades, sino de entropias. Segundo, es a priori _con respecto a la nueva evidencia_, no a priori con respecto a cualquier evidencia! O sea, la teoria Q juega el papel de teoria condicionada con evidencias previas, pero _no las nuevas_ (igual que en una secuencia de actualizaciones bayesianas el prior es el posterior de lo anteriormente inferido). De ahi el valor incremental informativo de la nueva evidencia, y su definicion cuantitativa en terminos de cuantos bits necesitare para describir la realidad.

Bueno, si tu teoría "se desvía", eso quiere decir que hace alguna predicción falsa, y por lo tanto su probabilidad a posteriori es 0, así que "para describir el fenómeno partiendo de las predicciones de la teoría" lo primero que haría falta sería tirar esa teoría a la basura y buscar otra cuyas predicciones fueran acertadas.

No, sigues con tu vision absolutista de confirmacion y refutacion. Tu teoria se desvia en tanto en cuanto no otorga la probabilidad "correcta" a lo observado, tiene grados.

No veo que haya tal cosa como "describir un fenómeno partiendo de ciertas predicciones": o bien las predicciones describen el fenómeno, o no lo describen.

Creo que te falta el concepto de entropia y su relacion con la compresion de datos. En resumen, una teoria precisa concentra mas probabilidad en lo que va a suceder, por tanto es menos sorprendida, y por tanto puede codificar la realidad de manera mas eficiente, con menos datos.

http://en.wikipedia.org/wiki/Information_theory#Kullback.E2.80.93Leibler_divergence_.28information_gain.29

Jesús,

ResponderEliminarcualquier cálculo de probabilidades se basa en dos cosas: la interacción entre algunos datos y algunas corazonadas, los datos solos no permiten inferir ninguna probabilidad

No estoy seguro de entenderte. Yo diría que nuestro cálculo de probabilidades no se basa en corazonadas, sino en teorías. Es una teoría, no una corazonada, la que me dice que es más probable obtener una cara al lanzar una moneda que un seis al lanzar un dado, por ejemplo.

Deutsch piensa que podemos prescindir de la parte de "animal spirit" que son las "corazonadas", pero yo pienso que no, que sin ellas sencillamente no podemos "arrancar" el proceso de razonamiento empírico, es decir, el proceso de extraer información sobre lo desconocido a partir de la información conocida.

De nuevo temo estar comprendiéndote mal. ¿Hablamos de creación de teorías o de valoración de teorías ya creadas?

Si hablamos de creación de teorías, me parece indudable que las corazonadas, la intuición, el "ya verás como los tiros van por aquí", pueden ser fundamentales (aunque quizá no sean imprescindibles).

Pero nosotros estábamos hablando, creo, de la valoración de teorías ya creadas, y aquí la cosa está menos clara. ¿Qué importa que a un científico le parezca muy probable una futura refutación de la Teoría General de la Relatividad, si todo su trabajo descansa sobre la aceptación de su validez?

si tenemos una teoría T que explica E (los hechos conocidos), pero nuestra "corazonada" no nos dice NADA sobre lo probable que es que T sea verdad (o sea, si no tenemos NINGUNA intuición sobre si p(T,E) es alto o bajo), entonces no podemos tener NINGUNA respuesta a la pregunta siguiente: "¿cómo de probable es que sea verdad la predicción F, que se sigue de T, pero que no se sigue de E?".

No comprendo a qué te refieres cuando dices que la predicción F se sigue de T pero no de E. ¿Cómo puede seguirse una predicción de E, es decir, de los hechos? Las predicciones sólo pueden seguirse de una teoría.

En cuanto a la pregunta de cómo de probable es F, no es cierto que no tengamos ninguna respuesta. Tenemos una: lo que diga T. Para lo que no tenemos ninguna es justo para lo otro, para calcular la probabilidad de que T sea falsa.

David

ResponderEliminares a priori _con respecto a la nueva evidencia_, no a priori con respecto a cualquier evidencia!

Claro, obviamente. Pero es arbitrario a partir de cuándo contar como "nueva": ¿la de la última hora?, ¿la del último año?, ¿la del último siglo?

.

sigues con tu vision absolutista de confirmacion y refutacion. Tu teoria se desvia en tanto en cuanto no otorga la probabilidad "correcta" a lo observado, tiene grados.

Bueno, eso depende. La teoría de Copérnico dice que las órbitas de los planetas son circulares, y por lo tanto predice que la probabilidad de observar una órbita elíptica es cero. Si comprobamos que las órbitas son elípticas, no tendremos que "revisar" la teoría de Copérnico, sino sustituirla por otra.

.

Yo no lo veo asi. Para mi la teoria de copernico tiene una probabilidd muy muy baja de ser cierta, pero no es exactamente cero.

EliminarEn todo caso, David, no estaría de más que ilustraras con algunos ejemplos cómo funcionaría la aplicación de esas fórmulas en una investigación científica normal y corriente, en particular, en una en la que no hay medidas precisas de probabilidad, sino sólo relaciones lógicas entre enunciados y juicios de plausibilidad, como suele pasar en la mayor parte de los casos.

ResponderEliminarJesus, como bien sabes, el esquema bayesiano es un modelo idealizado, en la practica normal y corriente los cientificos no siempre calculan probabilidades, ni hacen inferencia formal.

EliminarAhora bien, en cosmologia se estan utilizando estos metodos de manera creciente, he hecho un google search y tenemos por ejemplo esto:

http://arxiv.org/pdf/0803.4089.pdf (en concreto 6.2.2)

http://arxiv.org/pdf/astro-ph/0703191.pdf

http://www.cambridge.org/gb/knowledge/isbn/item2709977/?site_locale=en_GB (en concreto el capitulo 5)

Donde se habla de estimar la utilidad de experimentos futuros utilizando metodos similares, por ejemplo el fisher informaton matrix. (por cierto, gracias a esta conversacion me he dado cuenta de que la intuicion que tuve al principio sobre una metrica entre teorias se estudia bajo el nombre de information geometry)

EI

ResponderEliminarYo diría que nuestro cálculo de probabilidades no se basa en corazonadas, sino en teorías. Es una teoría, no una corazonada, la que me dice que es más probable obtener una cara al lanzar una moneda que un seis al lanzar un dado, por ejemplo

Lo que se basa (en parte) en "corazonadas" (o sea, juicios subjetivos no reducibles a ningún conjunto de datos objetivos) es cómo de probable nos parecen las teorías en función de los datos. Fíjate que, si sabemos que tanto A como B implican C y D, lo único que podemos inferir de ahí es que p(A,C&D) es mayor que p(A,C), etc. Pero no nos dice CUÁNTO. Dos personas que estén de acuerdo en que A implica C y B implica C, pueden una de ellas considerar que A es más probable que B, y otra que B es más probable que A.

Naturalmente, podemos tener la "teoría" de que A es mucho más plausible que B, pero eso es a lo que estoy llamando una "corazonada", es decir, un juicio subjetivo.

.

Luego sigo

“Bueno, eso depende. La teoría de Copérnico dice que las órbitas de los planetas son circulares, y por lo tanto predice que la probabilidad de observar una órbita elíptica es cero. Si comprobamos que las órbitas son elípticas, no tendremos que "revisar" la teoría de Copérnico, sino sustituirla por otra”.

EliminarEl núcleo de la teoría de Copérnico, lo que imposibilita su refutación, se basa en dos argumentos:

1) Copérnico es otro eslabón que se suma a los que creían en la teoría heliocéntrica, creencia que proviene de los egipcios y que atravesó el mundo griego.

2) Copérnico, como otros antes que él, postuló que la Tierra gira alrededor del sol, luego su teoría es correcta y por tanto no puede ser modificada, aunque sí mejorada.

Sustituir la teoría de Copérnico equivale a negar el heliocentrismo, ¿entonces cómo sustituyes el núcleo de su teoría? Corregir el asunto de las órbitas refuerza, paradójicamente, la consistencia de la teoría copernicana.

EI

ResponderEliminarsigo:

lo crucial es el hecho de que las relaciones deductivas que existen entre ciertas proposiciones son IRRELEVANTES para determinar CÓMO DE PROBABLE es una proposición que no se siga lógicamente de ellas. Sea E el conjunto de hechos empíricos conocidos hasta ahora, y que nuestras teorías deben explicar; sea T la mejor teoría que tenemos hasta ahora sobre esos hechos (fíjate que aquí ya hay un problema: puede que la mejor teoría que tengamos -y SUELE ser así- ni siquiera sea capaz de explicar TODO lo que está recogido en E, e incluso puede que algo de lo que está recogido en E CONTRADIGA a T); pero por ponerlo lo más favorable posible, supongamos que estamos en la situación ideal, en la cual T implica E. Obviamente, T implica también otras cosas (predicciones aún no contrastadas), p.ej., F, de modo que F es lógicamente independiente de E. La cuestión es, ¿cómo de probable consideramos que es F antes de contrastarla?

P.ej. podemos pensar que E es el conjunto de hechos explicados por la teoría de Newton hacia 1750, y F es la predicción de que el experimento de Cavendish dará tal o cual resultado.

Pues el caso es que conocer las relaciones lógicas existentes entre T, E y F, más nuestra aceptación de E, es INSUFICIENTE para determinar el grado de probabilidad con el que esperamos que ocurra F. Lo que necesitamos para asignar ALGUNA probabilidad a F es conocer cómo de grande es, más o menos, p(T,E), pues lo que sí sabemos es que, como F se sigue de T, p(F,E) será mayor que p(T,E). Si p(T,E) pensamos que es muy pequeña, pues entonces el hecho de que F se siga de T no tiene por qué hacer que F sea significativamente probable; en cambio, si p(T,E) es muy grande (como en el dibujo de esta entrada), entonces todo aquello que se siga de T, consideraremos que es también muy probable.

.

Por lo tanto, para que tenga sentido actuar sobre la base de las predicciones de una teoría (es decir, tomando esas predicciones como algo que probablemente se cumplirá, que es lo que hacemos de modo ordinario con nuestras "mejores" teorías) es IMPRESCINDIBLE que consideremos que la probabilidad de que esas teoría sean correctas (o al menos, aproximadamente correctas) sea una probabilidad significativamente alta. Pero como las relaciones deductivas entre las teorías y los hechos con los que las contrastamos es INSUFICIENTE para determinar esa probabilidad, se sigue de ahí que nuestros juicios de probabilidad se basan en ALGO MÁS aparte de las relaciones deductivas entre las teorías y los hechos. A ese "algo más" lo he llamado, siguiendo a otro comentarista, "corazonadas", pero me conformo con llamarlo "juicios subjetivos". Naturalmente, no hay ninguna garantía de que esas corazonadas sean correctas: igual que las teorías, nuestra única forma de justificarlas es sometiéndolas a contrastación.

.

¿Qué importa que a un científico le parezca muy probable una futura refutación de la Teoría General de la Relatividad, si todo su trabajo descansa sobre la aceptación de su validez?

Pues eso: mostrar que T implica los hechos E que queremos explicar con ella deja INDETERMINADO si p(T,E) es una cifra la leche de alta o ridículamente baja; pero si es ridículamente baja, eso quiere decir que las predicciones que hacemos con T también es posible que sean ridículamente improbables. Dicho de otro modo, "aceptar la validez" de T no consiste SÓLO en aceptar que T implica E, sino también en aceptar que la verdad (al menos la verdad aproximada) de T es SIGNIFICATIVAMENTE PROBABLE dado E. Pues "aceptar la validez" de una teoría significa considerar que podemos tomarla razonablemente como base para los cálculos de nuestras predicciones.

.

sigo

sigo

ResponderEliminarNo comprendo a qué te refieres cuando dices que la predicción F se sigue de T pero no de E. ¿Cómo puede seguirse una predicción de E, es decir, de los hechos? Las predicciones sólo pueden seguirse de una teoría.

Pues claro: eso es lo que estoy diciendo. F se sigue de T, no de E. Que el hecho F se cumpla no lo podemos inferir a partir de la premisa "se han cumplido los hechos E", sino que lo predecimos a partir de la premisa "la teoría T es verdadera". Si consideramos que esa premisa es extremadamente improbable, el hecho de que F se siga de T no lo hace probable, y por lo tanto, podemos considerar que F es muy improbable que se cumpla AUNQUE aceptemos los hechos E que T explica tan de puta madre.

.

Por otro lado, no olvides que TODO son teorías: los "hechos" incluidos en E también son conjeturas que hemos aceptado tras un proceso de contrastación.

.

.

En resumen, nuestro juicio sobre la "validez" de una teoría, y lo razonable que sea actuar sobre la base de sus predicciones, depende FUNDAMENTALMENTE de cómo de grande sea el área naranja de la figura de arriba (es decir, de cómo sea p(¬T,E) ). Newton lo tenía muy claro cuando se esforzó por mostrar que la ley de la gravedad podía ser DEDUCIDA de las leyes de Kepler (aunque, obviamente, no puede: hacen falta supuestos adicionales, que forman parte de la mecánica newtoniana); igualmente se ve esto claro al leer "El origen de las especies", donde Darwin se esfuerza por DEDUCIR la validez de la tesis de evolución por selección natural a partir de los hechos conocidos sobre los seres vivos, y no al revés.

.

In a nutshell: argumentar la "validez" de una teoría consiste en hacer todo lo posible para mostrar que, dado lo que sabemos, es extremadamente IMPROBABLE que la teoría no sea aproximadamente correcta. Deutsch quiere jugar al juego de la ciencia olvidándose de la importancia de los juicios sobre lo probables o improbables que son las proposiciones, y fijándose sólo en las relaciones deductivas entre esta, y eso equivale sencillamente a querer nadar en una piscina sin agua, o, como la paloma de Kant, querer volar eliminando la resistencia del aire.

nose si jugar al juego, no creo que sea necesario darle así con todo, nose si me explico?

Eliminarmi que Jugar Cahrlie Sheen - juegos gratis, por ejemplo no es un tipo como aparenta ser, yo lo cree como un gran filoso de nuestro tiempo,todo es cuestión de perspectiva y con el cristal con que lo mires.

EI

ResponderEliminarEn cuanto a la pregunta de cómo de probable es F, no es cierto que no tengamos ninguna respuesta. Tenemos una: lo que diga T

No, eso no lo "tenemos" MÁS QUE si aceptamos que es PROBABLE que T sea verdadera. Insisto, es posible que T implique E (los hechos conocidos), pero aún así consideremos que T sea muy improbable, y por lo tanto, el hecho de que F se siga de T sea IRRELEVANTE para determinar si F es probable o improbable.

Anónimo:

ResponderEliminarno seré yo el que niegue la importancia de distinguir el "núcleo" de una teoría y su "periferia", pero entonces la cosa se vuelve aún mucho peor para un bayesianismo naif, pues simplemente no hay manera de estimar las probabilidades de cada hipótesis por separado, más que la pura intuición subjetiva. En la última parte del artículo que cité el otro día hablaba sobre esto.

Jesús, mi comentario no valora el bayesianismo fuerte o débil sino tu sorprendente afirmación acerca de la refutación/sustitución de la teoría de Copérnico. Podremos sustituir la teoría de Copérnico por contradictoria pero no podremos refutar el heliocentrismo cuyo origen se remonta a la noche de los tiempos. Hay teorías que son irrefutables, al menos en el plano tridimensional, aunque sean mejorables, y el heliocentrismo es una de ellas. El hecho de que las órbitas planetarias circulares predichas por Copérnico se hayan demostrado falsas no sólo no invalida su teoría sino que la refuerza tan pronto se descubrió que dichas órbitas son elípticas. Esto es lo que tienen las buenas teorías, que sus imperfecciones no logran derribarlas.

ResponderEliminarAnónimo:

ResponderEliminares que no sé de qué te sorprendes; yo me refería a la teoría de Copérnico, no al heliocentrismo. Si hubiera querido hacer una afirmación sobre el heliocentrismo en general, lo habría hecho así.

Jesús,

ResponderEliminarHe leído tu comentario con calma, pero sólo puedo dedicarle unos pocos minutejos a su respuesta, así que disculpa si resulto más caótico que d'habitude.

Mi intención es exponer una discrepancia y media, pero antes de entrar en faena quiero decirte, porque supongo que estas cosas siempre animan, que tu teoría me parece cada vez más convincente. De hecho voy a decir algo muy gordo: creo que toda esta historia de las probabilidades subjetivas, como la de la cantidad de pruebas necesaria para aceptar una teoría, que discutimos hace un mes, representan una superación de algunas de las tesis de Deutsch que yo he venido defendiendo.

sigo

ResponderEliminarpara que tenga sentido actuar sobre la base de las predicciones de una teoría (...) es IMPRESCINDIBLE que consideremos que la probabilidad de que esas teoría sean correctas (o al menos, aproximadamente correctas) sea una probabilidad significativamente alta.

No es imprescindible. Hay muchas ocasiones en que no es así. Es probable que la inmensa mayoría de los científicos tenga la práctica convicción de que la Teoría de la Relatividad será falsada algún día. Esto, sin embargo, no les impide por lo general aceptar sus predicciones o basar en ella nuevas teorías.

Una manera más dinámica de plantear esto mismo sería la deutschiana. En lugar de partir de una teoría ya creada, analicemos el momento mismo de su creación. Imaginemos que necesitamos calcular la probabilidad de que ocurra un determinado fenómeno. ¿Qué podemos hacer? En principio, tenemos dos opciones:

1. Calcularla al azar, a ojo, guiados por nuestras intuiciones.

2. Analizar la situación y tratar de comprender lo que puede estar pasando, con la esperanza de que esa comprensión nos ayude a calcular la probabilidad.

Imaginemos ahora que elegimos la segunda opción y que, después de un rato meditando, encontramos una teoría que nos permite calcular la probabilidad de marras. La examinamos, le buscamos errores y no le encontramos ninguno. Nuestra intuición, sin embargo, nos dice que la teoría es pésima. No podemos decir nada concreto contra ella, pero tiene "mala pinta". ¿Qué hacemos? De nuevo dos opciones:

1. Calculamos la probabilidad al azar, por pura intuición.

2. Calculamos la probabilidad con esa teoría probablemente pésima porque, a falta de pan, buenas son tortas.

El mero hecho de que podamos plantearnos esta disyuntiva indica que, para actuar conforme a una teoría, en modo alguno resulta imprescindible atribuirle una alta probabilidad subjetiva de ser cierta o aproximadamente cierta (aunque para calcular esta proximidad haya que emplear, con cierta circularidad, las propias probabilidades subjetivas).

En resumen: si necesitamos calcular la probabilidad de un fenómeno, sería perfectamente racional preferir aquellos cálculos que se basan en una razón, por endeble que nos parezca, a aquellos que se basan en el puro azar. O, parafraseando una frase de George Moore sobre los chistes en las conferencias: "Better a bad theory than no theory".

sigo

ResponderEliminarDeutsch quiere jugar al juego de la ciencia olvidándose de la importancia de los juicios sobre lo probables o improbables que son las proposiciones, y fijándose sólo en las relaciones deductivas

Si con eso de las relaciones deductivas quieres decir que a Deutsch le basta con que la teoría implica T implique E, que me parece entender que es lo que estás diciendo, te equivocas por completo. Deutsch no dice semejante cosa. Lo que dice, para lo que ahora nos interesa, es lo mismo que tú unas líneas más arriba:

"aceptar la validez" de una teoría significa considerar que podemos tomarla razonablemente como base para los cálculos de nuestras predicciones.

Esta es su solución, de hecho, al problema de la inducción.

Las diferencias entre vosotros, por lo tanto, no están ahí, sino en vuestro análisis de los factores que nos llevan a la aceptación de una teoría. En tu planteamiento, una teoría no está aceptada (no consideramos razonable calcular con ella nuestras predicciones) hasta que no le asignamos, a ojo, una probabilidad muy alta de ser cierta. En el planteamiento deutschiano, una teoría está aceptada (consideramos razonable calcular con ella nuestras predicciones) cuando es la mejor que tenemos, que a su vez quiere decir que fue la única que sobrevivió a todas nuestras objeciones durante un debate popperiano.

Por último, algo que no creo que no es una objeción, sino una simple observación.

ResponderEliminarEn tu planteamiento, la probabilidad subjetiva que le asignamos a una teoría no parece que esté pensada para convertirse en número, sino para reducirse a dos únicas valoraciones cualitativas: probabilidad alta (=teoría aceptada) y probabilidad baja (=teoría no aceptada).

EI

ResponderEliminar.

quiero decirte, porque supongo que estas cosas siempre animan, que tu teoría me parece cada vez más convincente. De hecho voy a decir algo muy gordo: creo que toda esta historia de las probabilidades subjetivas, como la de la cantidad de pruebas necesaria para aceptar una teoría, que discutimos hace un mes, representan una superación de algunas de las tesis de Deutsch que yo he venido defendiendo.

¡¡¡Yupiyupiyupi!!!

.

Es probable que la inmensa mayoría de los científicos tenga la práctica convicción de que la Teoría de la Relatividad será falsada algún día.

Claro, pero porque lo que piensan es que la teoría de la relatividad es MUY PROBABLEMENTE MUY APROXIMADAMENTE VERDADERA en los ámbitos en los que está confirmada, y que cualquier teoría que la sustituya tendrá que permitir derivar una versión muy aproximada de lo que se sigue de ella, como las conclusiones de la teoría de Newton se siguen muy aproximadamente de la relatividad.

.

para actuar conforme a una teoría, en modo alguno resulta imprescindible atribuirle una alta probabilidad subjetiva de ser cierta o aproximadamente cierta

Bueno, tal como entiendo yo tu ejemplo, lo que estamos haciendo en ese caso es un razonamiento hipotético: "SUPONGAMOS que la teoría tal fuese verdadera, o aproximadamente correcta", luego lo que estás SUPONIENDO que es hay una probabilidad 1 de que la teoría es aproximadamente correcta... aunque obviamente puede ser una suposición contrafáctica porque SABES, o sospechas, que es muy probable que sea falsa. Pero no veo ninguna diferencia apreciable entre "suponer que la teoría T es verdadera" y "suponer que la probabilidad de que la teoría T sea verdadera es 1"

.

si necesitamos calcular la probabilidad de un fenómeno, sería perfectamente racional preferir aquellos cálculos que se basan en una razón, por endeble que nos parezca, a aquellos que se basan en el puro azar

Es que tú estás suponiendo que "basado en una razón (es decir, en una teoría)" y "basado en el puro azar" son dos cosas distintas, y no lo son: cualquier suposición acerca de la forma, todo lo imprecisa que sea, de la "distribución de probabilidad subyacente" YA es una teoría. La cuestión es que hay teorías DE ESAS (o sea, conjeturas acerca de la distribución subyacente de probabilidad) que tendemos a hacer "por defecto", que nos parecen más "naturales" o "intuitivas".

.

"aceptar la validez" de una teoría significa considerar que podemos tomarla razonablemente como base para los cálculos de nuestras predicciones.

Esta es su solución, de hecho, al problema de la inducción.

Pues no veo lo que quieres señalar: mi cuestión es a qué demonios se refiere Deutsch cuando dice "razonablemente". ¿Quiere decir que la teoría ha conseguido explicar los hechos, y que ninguna otra lo ha conseguido? ¿O qué quiere decir exactamente? ¿CUÁNDO es "razonable" considerar una teoría como base para nuestras predicciones?

.

En tu planteamiento, una teoría no está aceptada (no consideramos razonable calcular con ella nuestras predicciones) hasta que no le asignamos, a ojo, una probabilidad muy alta de ser cierta.

No exactamente: yo no pienso que nuestros juicios subjetivos de probabilidad sean mera cuestión de "estimar a ojo". Pienso que están influidos también por consideraciones más "metodológicas", "epistemológicas", "metafísicas", e incluso montones de prejuicios. P.ej., la resistencia de los cartesianos a aceptar la acción a distancia newtoniana (y por tanto, a conceder una probabilidad muy baja a la teoría de la gravedad, por mucho éxito empírico que tuviera) se basaba en un prejuicio metafísico más que nada.

.

sigo

sigo

ResponderEliminar.

En el planteamiento deutschiano, una teoría está aceptada (consideramos razonable calcular con ella nuestras predicciones) cuando es la mejor que tenemos, que a su vez quiere decir que fue la única que sobrevivió a todas nuestras objeciones durante un debate popperiano.

Pues eso es lo que digo yo que él dice. Y digo que está mal: una teoría puede haber sido la única que ha "sobrevivido", y a pesar de eso parecernos pésima, implausible. Es decir, puede ser que sea la única no refutada por los hechos E, la única que consigue explicarlos, pero aun así, cuando consideramos OTRA de sus consecuencias, F, que es distinta de E, pensemos que la probabilidad de que F sea verdadera es muy pequeña. Es decir, el argumento que falta en Deutsch (y en Popper) es precisamente el de mostrar por qué es razonable apostarse el escroto por la verdad de F sólo sobre la base de que T es nuestra mejor explicación de E y de que T implique F.

.

la probabilidad subjetiva que le asignamos a una teoría no parece que esté pensada para convertirse en número, sino para reducirse a dos únicas valoraciones cualitativas: probabilidad alta (=teoría aceptada) y probabilidad baja (=teoría no aceptada).

Más o menos, pero no exactamente: lo que hago es asumir que los científicos establecen COMPARACIONES de probabilidad.

"lo que hago es asumir que los científicos establecen COMPARACIONES de probabilidad."

ResponderEliminar¿"Supongamos que la vaca es esférica", como dice Héctor?. ¿Los científicos establecen comparaciones de probabilidad según tu modelo o nos resulta útil (todavía no he entendido para qué) suponer que hacen tal cosa?. No entiendo cómo un modelo matemático puede resultar más útil que un trabajo de campo a la hora de averiguar los criterios de la comunidad científica a la hora de elegir entre teorías.

Masgüel:

ResponderEliminarde la misma manera que un modelo matemático puede ser más útil para elegir teorías astronómicas que el "trabajo de campo"; por otro lado, no se trata de si es "más" útil, sino de si es útil. El "trabajo de campo" ya lleva muchísimos años hecho, por parte de historiadores y sociólogos de la ciencia, y nos ha proporcionado un montón de datos sobre en qué circunstancias prefieren los científicos unas teorías a otras, o en qué circunstancias consideran que las teorías han mejorado o empeorado. Lo que yo pretendo es ENTENDER por qué tienen ESOS criterios en vez de tener otros. Y para eso sirven los modelos.

Jesús,

ResponderEliminarlo que piensan es que la teoría de la relatividad es MUY PROBABLEMENTE MUY APROXIMADAMENTE VERDADERA en los ámbitos en los que está confirmada

No importa. La cuestión es que los científicos pueden estar convencidos de que alguno o algunos postulados de la teoría einsteiniana pueden estar muy alejados de la realidad (tan alejados como el tiempo absoluto del tiempo relativo, digamos), pero esto no les impide usar la teoría en su conjunto para hacer todo tipo de predicciones y para construir sobre ella otras muchas teorías nuevas.

Por otro lado, debo insistir de nuevo en la posible circularidad de tu teoría: utilizas la estimación subjetiva de probabilidad para definir el concepto de proximidad a la verdad, pero al mismo tiempo dices que la probabilidad que estimamos es la probabilidad de que una teoría sea aproximadamente verdadera.

tal como entiendo yo tu ejemplo, lo que estamos haciendo en ese caso es un razonamiento hipotético

No, lo que estamos haciendo es decidir entre dos opciones: decidir algo apoyados en una razón que la intuición nos dice que es mala, pero a la que no le encontramos ningún fallo por más que la examinamos, o decidirlo al azar.

Es que tú estás suponiendo que "basado en una razón (es decir, en una teoría)" y "basado en el puro azar" son dos cosas distintas

Y lo son. Una cosa es calcular el lugar donde caerá un proyectil guiados por las razones de la mecánica newtoniana y otra muy distinta dejando caer nuestro dedo sobre un mapa con los ojos cerrados.

cualquier suposición acerca de la forma, todo lo imprecisa que sea, de la "distribución de probabilidad subyacente" YA es una teoría.

El nombre es lo de menos. Lo esencial es que algunas de esas suposiciones o teorías podemos aceptarlas por alguna razón o por ninguna, llevados por la pura intuición.

¿CUÁNDO es "razonable" considerar una teoría como base para nuestras predicciones?

Cuando tenemos razones para considerar que es la mejor. ¿Y cuáles son esas razones? Las que se consideren pertinentes en cada caso (en cada debate popperiano).

yo no pienso que nuestros juicios subjetivos de probabilidad sean mera cuestión de "estimar a ojo". Pienso que están influidos también por consideraciones más "metodológicas", "epistemológicas", "metafísicas", e incluso montones de prejuicios.

Si esas consideraciones son el tipo de cosa que podrían funcionar como razones durante un debate popperiano, entonces no hay ninguna diferencia apreciable con Deutsch. La navaja de Occam, por ejemplo, o el ya famoso criterio de la facilidad o dificultad para ser variada de una teoría, podrían incluirse sin problema en ese catálogo de consideraciones metodológicas, epistemológicas, etc.

Y digo que está mal: una teoría puede haber sido la única que ha "sobrevivido", y a pesar de eso parecernos pésima, implausible. Es decir, puede ser que sea la única no refutada por los hechos E

Dos observaciones muy importantes (de hecho, aquí está el núcleo de la discusión):

1. Las teorías no son refutadas por los hechos, o no sólo por los hechos: son refutadas por argumentos, y esos argumentos pueden ser de todo tipo. Pueden ser argumentos del tipo "Este hecho contradice esta predicción de la teoría", en efecto, como pueden ser también del tipo "Esta teoría introduce demasiadas hipótesis ad hoc". Es decir: esos argumentos pueden incluir las consideraciones metodológicas, epistemológicas, etc, de las que hablábamos hace un momento.

2. En situación de necesidad, no importa que nuestra mejor teoría nos parezca pésima. La usaremos igualmente porque no tenemos otra, porque nuestra alternativa sería usar las otras, las todavía peores.

Ei

ResponderEliminar.

Error: no es para hacer "todo tipo de predicciones"; sólo se confía que serán válidas las predicciones que se hacen en aquellos ámbitos en los que ya se ha confirmado que las predicciones salen bien, o en aquellos en los que no hay razones para sospechar que saldrán mal. En los ámbitos en los que no tenemos seguridad de que los postulados de la TR sean aproximadamente correctos, nuestros cálculos los cogemos con papel de fumar.

.

la posible circularidad de tu teoría: utilizas la estimación subjetiva de probabilidad para definir el concepto de proximidad a la verdad, pero al mismo tiempo dices que la probabilidad que estimamos es la probabilidad de que una teoría sea aproximadamente verdadera.

Es que no es una circularidad: las estimaciones de probabilidad son PRIMITIVAS en mi modelo (el modelo no explica de dónde vienen, las toma como dadas), y se calcula la verosimilitud en función de ellas. Lo que digo es que SI los científicos tienen razones para pensar que p(T,E) es muy baja pese a que T implique E, entonces no asignarán necesariamente una probabilidad elevada a las otras consecuencias que se sigan de T. Pero que tengan esas razones o las dejen de tener, depende de ellos, no es algo que se siga de mi modelo.

.

o que estamos haciendo es decidir entre dos opciones: decidir algo apoyados en una razón que la intuición nos dice que es mala, pero a la que no le encontramos ningún fallo por más que la examinamos, o decidirlo al azar.

Bueno, en el caso que considerábamos, era una mera cuestión semántica: hacer un razonamiento del tipo "T implica F" es lo mismo que decir "si T es verdad, F es verdad", y decir "si T es verdad" es lo mismo que decir "si T ocurre de modo máximamente probable". Si, por otro lado, pensamos que T no es verdad, pues ese razonamiento es un contrafáctico, como se hacen miles de veces y no pasa nada.

.

sigo

sigo

ResponderEliminarUna cosa es calcular el lugar donde caerá un proyectil guiados por las razones de la mecánica newtoniana y otra muy distinta dejando caer nuestro dedo sobre un mapa con los ojos cerrados.

Claro que son distintas, pero porque son predicciones basadas en TEORÍAS distintas, no porque una sea una predicción basada en una teoría y otra una predicción no basada en una teoría.

.

Lo esencial es que algunas de esas suposiciones o teorías podemos aceptarlas por alguna razón o por ninguna, llevados por la pura intuición

No. Porque lo que estamos discutiendo es si el hecho de que

1) T implique E,

2) ninguna otra teoría conocida implique E, y

3) T implique F, que es independiente de E,

discutimos, digo, si la combinación de estas tres cosas es o no es una RAZÓN para aceptar que F es probablemente verdadero. Lo que yo digo es que no lo es, SALVO que p(T,E) sea relativamente alta.

.

¿CUÁNDO es "razonable" considerar una teoría como base para nuestras predicciones?

Cuando tenemos razones para considerar que es la mejor.

De nuevo no: no se trata de si es "la mejor", sino de CUÁNTO DE BUENA ES. Puede que la mejor que tengamos sea una mierda, y no nos la tomemos en serio para hacer predicciones con ella.

.

Fíjate en la cuestión de los puntos 1-2-3 en un momento posterior: YA hemos comprobado si se cumple F (y G, y H, y J, etc.), es decir, todas las demás predicciones que T había hecho ADEMÁS DE E... ¡pero hemos comprobado que no se cumplen! ¡Y seguimos sin tener ni idea de cómo formular otra teoría que explique E (y F, y G, etc.)! Ahora hacemos una nueva predicción con T, sea L, que también es independiente de E, F, G, etc. ¿Tenemos razones para creer que L será correcta, sólo porque se sigue de T? Parece claro que no. ¿Y si hubiéramos predicho L antes de averiguar empíricamente que F, G, etc., eran falsas? Pero, ¿cómo puede afectar nuestro conocimiento de que F, G,..., son falsas a nuestra creencia en si se cumple L o se deja de cumplir, dado que L es independiente de ellas?

.

En resumen, nuestra creencia en lo justificadas que están las predicciones NUEVAS que hacemos con T no depende SÓLO de si T es la mejor teoría que tenemos hasta ahora, sino TAMBIÉN depende de CÓMO DE BUENA pensamos que es (es decir, de p(T,E)).

.

sigo

Si esas consideraciones son el tipo de cosa que podrían funcionar como razones durante un debate popperiano, entonces no hay ninguna diferencia apreciable con Deutsch.

ResponderEliminarCreo que sí lo hay, porque Popper estaría dispuesto a admitir muchas consideraciones "metafísicas" o "filosóficas" en esas razones, pero Deutsch creo que no. Claro, que tal vez me equivoque, y en ese caso, doy la bienvenida a Deutsch al campo de los que creemos que las consideraciones "metafísico - filosóficas" entran en el tipo de razones que son relevantes para determinar cómo de aceptable nos parece una teoría.

Por otro lado, si por "debate popperiano" quieres decir un debate en el que los argumentos respetan las reglas de la lógica, incluyendo la lógica "informal" (argumentos de analogía, inductivos, etc.), pues entonces, claro, ¿qué otra cosa va a ser un debate si no?

.

En situación de necesidad, no importa que nuestra mejor teoría nos parezca pésima. La usaremos igualmente porque no tenemos otra

No. Si p(F,E) nos parece ridículamente bajo aunque p(F,T) sea igual a 1, nuestra predicción será, de hecho, NO-F, más bien que F.

Perdón, EI, mi primer comentario era respuesta a esta frase tuya:

ResponderEliminar"La cuestión es que los científicos pueden estar convencidos de que alguno o algunos postulados de la teoría einsteiniana pueden estar muy alejados de la realidad (tan alejados como el tiempo absoluto del tiempo relativo, digamos), pero esto no les impide usar la teoría en su conjunto para hacer todo tipo de predicciones"