LO PÚBLICO Y TÚ

En teoría económica se entiende por "bien público" algo distinto al sentido que tiene esta palabra en el lenguaje ordinario (digamos, "algo que pertenece a todos, o que pertenece al Estado, o a una entidad pública"). El significado económico del término es, más bien, el de un bien que posee estas dos propiedades:

.

1) el hecho de que una persona más lo consuma o disfrute de él, no disminuye la cantidad disponible para los demás ("principio de no rivalidad")

.

2) una vez que el bien se suministra a alguien, no se puede impedir que cualquier otra persona lo consuma ("principio de no exclusión").

.

Propiamente hablando, hay muy pocos bienes que cumplan los dos requisitos, pues en la mayoría de los casos el que haya más usuarios hace que aumente la "congestión" (y por lo tanto, los demás puedan disfrutar del bien en menor medida), y siempre podríamos ejecutar sumariamente a quienes no han sufragado esos bienes. Así que en general se suele entender por "bienes públicos" más bien aquellos en los que: a) sería excesivamente costoso excluir de su consumo a quienes no los pagan, y b) en los límites de uso habitual, no hay excesivos problemas de congestión.

.

Pero lo cierto es que, pese a este ejercicio de estiramiento semántico, los bienes públicos siguen siendo realmente pocos en comparación con todos aquellos que normalmente se proporcionan o gestionan desde el sector público. Por ejemplo, los tres "pilares básicos" del estado del bienestar, educación, sanidad y seguridad social (pensiones y seguro de desempleo) no son bienes públicos (en el sentido económico del término), sino bienes de disfrute básicamente privado: tú eres a quien se opera de apendicitis, no a tu vecino que está sano; tú eres quien manda sus hijos al colegio, no tu compañero de trabajo solterón y sin hijos; y a cada uno se le ingresará la pensión o la prestación por desempleo en su cuenta corriente, no en la del cuñado. Cierto que el disfrute de estos bienes producen "externalidades" (el nivel de salud medio de la población, su nivel educativo, etc.) de las que se benefician también, indirectamente, quienes no los han disfrutado directamente, pero eso no hace de ellos "bienes públicos" en sentido económico. A estos bienes habría que llamarlos más bien "servicios sociales". Además, aunque la sociedad decida de una u otra manera que todo el mundo tiene derecho igual a estos servicios, no hay ningún argumento económico que justifique a priori que estos servicios tengan que ser prestados por las administraciones públicas: éstas pueden, en principio, limitarse a financiarlos, pero dejando que sean empresas privadas quienes los produzcan y gestionen (como, p.ej., en el caso de los "colegios concertados"). Naturalmente, tampoco hay ningún argumento económico razonable por el que a priori no puedan ser prestados por organismos públicos. Tendrá que ser algo a decidir en función de los costes previsibles y las preferencias de la gente.

.

Algunos bienes que cumplen los requisitos 1 y 2 (aunque sea de modo aproximado) serían, por ejemplo, muchas infraestructuras, las señales de radio y televisión no codificadas, las leyes, el idioma, la defensa nacional, el sistema judicial... Pero, como seguramente estaréis pensando, en muchos casos es posible, y hasta factible, el limitar el uso de algunos de estos bienes a ciertas personas: en las carreteras se pueden poner peajes, las ondas de radio (e incluso los códigos del habla) se pueden codificar, los tribunales pueden poner una oficina de cobros a la entrada, etc., etc.

.

La cuestión es que, igual que en el caso de los servicios sociales hemos de decidir en qué cantidad financiarlos, a quién beneficiar con ellos, y cómo producirlos, lo mismo ocurre con el caso de los bienes públicos propiamente dichos: ¿establecemos tasas judiciales?, ¿más peajes?, ¿construirmos más o menos carreteras?, ¿dotamos más o menos juzgados?, etc., etc.

.

Pero el sentido de esta nueva serie de entradas no es insistir en esto último, tan obvio, sino más bien en el hecho de que la diferencia entre los bienes públicos y privados es en sí misma sutil y borrosa: limitando el acceso a un bien público deja de ser público, financiando públicamente un bien privado se convierte en un bien social. Hay una cuestión importante, que es previa a decidir políticamente es qué queremos que sea público y/o social: la cuestión de quiénes queremos que se beneficien de un determinado bien o servicio. Un bien que es público dentro de ciertos límites pero privado fuera de ellos es lo que se llama en economía un "bien de club". Pensad en una instalación deportiva de propiedad privada, como una piscina: sólo los socios pueden entrar, pero una vez que están dentro, la piscina es para ellos un bien público, tan público como una piscina pública (no les perjudica gran cosa que haya un bañista más, y la cantidad de agua en la piscina es la misma para todos). El economista James Buchanan formuló en 1965 una preciosa teoría sobre el tamaño óptimo de los clubs (tamaño tanto en el sentido de qué cantidad del bien se ofrecía en ellos, como en el sentido del número óptimo de miembros, teniendo en cuenta que cuanto mayor es la cantidad y menor el número de miembros, mayor será la "cuota" que le toque pagar al individuo).

.

Pues bien, la mayoría de los bienes y servicios son en realidad "bienes de club": incluso la defensa nacional consiste precisamente en un mecanismo para beneficiar a los insiders, ¿no? Lo que sugiero con esta entrada y las que siguen es, por un lado, que reflexionemos sobre los bienes públicos y servicios sociales precisamente como ejemplos de "clubs" que podemos desear en mayor o menor medida, cuál sería la distribución y producción óptima de esos "clubs" en nuestra opinión, que políticas redistributivas serían más apropiadas con esta concepción en mente de los bienes públicos, qué diferencias ideológicas habría sobre estas cuestiones, etc., Y por otro lado, pensar si no estamos caminando hacia una sociedad en la que lo público-estatal tiende a ser sustituido por lo privado-colectivo, en donde, en lugar de centrar toda la carga de la "justicia social" en la acción de un único agente que sería la administración pública, no se abren "focos de socialización" no-estatales (o incluso, con las reivindicaciones independentistas, instancias que podrían ser consideradas como estados-club). No digo a priori que esta tendencia sea buena o mala; me limito a expresar mi sospecha de que es la tendencia actual de la historia, y que debemos decidir si contrapesarla, si unirnos a ella, o a dónde y a qué ritmo intentar dirigirla.

.

27 de noviembre de 2012

26 de noviembre de 2012

22 de noviembre de 2012

OPPA HAYEK STYLE

Añade AQUÍ tu firma del manifiesto que han escrito el prof. Juan Ramón Rallo y otros cuantos profesores ideológicamente afines al PP de la Universidad Rey Juan Carlos, en el que se pide el desmantelamiento inmediato de dicha universidad y el despido fulminante de todos sus trabajadores, para darle a España una lección de austroliberalismo en las propias carnes de sus bien colocados defensores.

21 de noviembre de 2012

ENTRE TODOS LA MATARON...

La reciente discusión

sobre las teorías de David Deutsch me vino a la memoria la semana pasada al

escuchar una charla del filósofo Kyle Stanford.

Éste sostiene que la estructura institucional de la ciencia contemporánea, con

su insistencia en el peer review, los controles políticos, y presión por

publicar, han fomentado una posición "realista",

"acrítica", "dogmática" entre los científicos, que a su vez

ha llevado a la ciencia a frenar el ritmo y la importancia de sus

descubrimientos. Salir de esta "estanflación epistémica" (el término

es mío) requeriría, según Stanford, que los investigadores se adhiriesen a la

interpretación instrumentalista del conocimiento científico, precisamente la

interpretación defendida por él en su libro Exceeding our grasp. En esta obra se argumenta que,

igual que las teorías actuales solieron ser simplemente y llanamente

inimaginables, inconcebibles, para los científicos del pasado, quienes estaban

básicamente seguros de que sus propias teorías (hoy desechadas) eran correctas

en lo fundamental, igual que eso ocurría, digo, también es de esperar que

ocurra que gran parte de las teorías científicas aceptadas hoy en día se consideren

como radicalmente equivocadas dentro de unos siglos. El éxito empírico de una

teoría, por muy grande que sea, no justifica suficientemente la aceptación de

dicha teoría como verdadera, pues es harto probable que la verdad esté,

sencillamente, "fuera de nuestra capacidad de comprensión" (al menos,

fuera de nuestra capacidad actual de comprensión).

La reciente discusión

sobre las teorías de David Deutsch me vino a la memoria la semana pasada al

escuchar una charla del filósofo Kyle Stanford.

Éste sostiene que la estructura institucional de la ciencia contemporánea, con

su insistencia en el peer review, los controles políticos, y presión por

publicar, han fomentado una posición "realista",

"acrítica", "dogmática" entre los científicos, que a su vez

ha llevado a la ciencia a frenar el ritmo y la importancia de sus

descubrimientos. Salir de esta "estanflación epistémica" (el término

es mío) requeriría, según Stanford, que los investigadores se adhiriesen a la

interpretación instrumentalista del conocimiento científico, precisamente la

interpretación defendida por él en su libro Exceeding our grasp. En esta obra se argumenta que,

igual que las teorías actuales solieron ser simplemente y llanamente

inimaginables, inconcebibles, para los científicos del pasado, quienes estaban

básicamente seguros de que sus propias teorías (hoy desechadas) eran correctas

en lo fundamental, igual que eso ocurría, digo, también es de esperar que

ocurra que gran parte de las teorías científicas aceptadas hoy en día se consideren

como radicalmente equivocadas dentro de unos siglos. El éxito empírico de una

teoría, por muy grande que sea, no justifica suficientemente la aceptación de

dicha teoría como verdadera, pues es harto probable que la verdad esté,

sencillamente, "fuera de nuestra capacidad de comprensión" (al menos,

fuera de nuestra capacidad actual de comprensión).

.

Me acordaba de lo de David Deutsch porque, precisamente, este otro

autor argumenta que el estancamiento de la ciencia moderna, y su borreguil

sometimiento a las instituciones que encorsetan la innovación, son, por el

contrario, resultado de la adhesión de los científicos a las perniciosas

doctrinas del instrumentalismo, el empirismo y el positivismo, y que sólo un

"valiente" realismo será capaz de devolver a la historia de la

ciencia su frescura de antaño.

.

Mi opinión sobre este debate (debate en mi cabeza, porque ni

Deutsch ni Stanford saben nada el uno del otro) es que ambos pecan de un

excesivo optimismo intelectual, al atribuir demasiados poderes causales a las

ideas filosóficas criticadas o defendidas por cada uno: seguramente ni el ser

realista ni el ser positivista está estadísticamente correlacionado, y mucho

menos causalmente conectado, con el que la ciencia progrese más o menos, y

tampoco tengo muy claro que el sistema científico actual haya realmente

"frenado" el ritmo de descubrimientos científicos (seguramente ha

sido más bien al revés). Quizá el síndrome de Manrique ("cualquiera tiempo

pasado fue mejor") se deba en este caso meramente al hecho de que en los

últimos 200 años se descubrió casi todo lo "espectacular", y ya sólo

quedan por resolver, al menos con nuestros alcances, cuestiones que, comparadas

con otras, parecen más bien detalles técnicos, poco susceptibles de despertar las

ensoñaciones y la ilusión de científicos y no científicos como lo hicieron las

teorías de los científicos más legendarios.

14 de noviembre de 2012

UNA MODESTA PROPOSICIÓN DE CURRÍCULO ESCOLAR SIMPLIFICADO

A la luz de la reflexión de Luis Garicano que citábamos aquí el otro día. Vaya desde aquí una modesta propuesta de currículo escolar supersimplificado para la primera fase de la educación secundaria (que podría ir de los 10 a los 15 ó 16 años). Para la enseñanza primaria podría valer un esquema parecido, mientras que para el bachillerato o la enseñanza profesional, se introducirían más optativas, claro.

.

Suponiendo 7 períodos lectivos diarios, o sea, una semana de 35 períodos lectivos (u "horas" de 45 -50 minutos), tendríamos:

.

- 8 horas de matemáticas (matemáticas "puras" y "aplicadas", es decir, incluyendo numerosos problemas de aplicación a la física, economía y cuanto hubiera menester).

.

- 8 horas de lengua o lenguas propias (que, como en su mayor parte se debería dedicar a enseñar a redactar y comentar textos y a exponer en público argumentos, se aprovecharía también para reflexionar y debatir sobre los temas de dichos textos y argumentos).

.

- 8 horas de inglés (o, para aquellos que han alcanzado un nivel suficiente de inglés, se pueden sustituir algunas de estas horas por otra lengua extranjera; y con la misma indicación que en el caso anterior)

.

Esto nos da 24 horas, que serían el núcleo principal de la enseñanza media. Las otras 11 horas se podrían distribuir de la manera siguiente:

.

- 4 horas de alguna ciencia (saber en qué mundo vives): un año geografía, otro historia, otro biología, otro geología, otro química; naturalmente, el reparto es flexible.

.

- 3 horas de aprendizaje para la vida: nociones sobre el sistema legal y político, reflexión filosófica, vida saludable física y mentalmente, vida laboral, actividades solidarias. A repartir de manera quodlibetal en los diversos cursos.

.

- 4 horas de para el desarrollo físico y cultural: deporte, música, teatro, danza, etc.

.

Las 7 últimas horas podrían incluso suprimirse del currículo "oficial", e "impartirse" (o lo que fuera más conveniente) en horario de tardes en grupos más diversificados y opcionales. Es decir, al final de la secundaria cada alumno tendría que haber hecho un mínimo de actividades de cada tema, pero puede elegirlas como le apetezca.

.

Suponiendo 7 períodos lectivos diarios, o sea, una semana de 35 períodos lectivos (u "horas" de 45 -50 minutos), tendríamos:

.

- 8 horas de matemáticas (matemáticas "puras" y "aplicadas", es decir, incluyendo numerosos problemas de aplicación a la física, economía y cuanto hubiera menester).

.

- 8 horas de lengua o lenguas propias (que, como en su mayor parte se debería dedicar a enseñar a redactar y comentar textos y a exponer en público argumentos, se aprovecharía también para reflexionar y debatir sobre los temas de dichos textos y argumentos).

.

- 8 horas de inglés (o, para aquellos que han alcanzado un nivel suficiente de inglés, se pueden sustituir algunas de estas horas por otra lengua extranjera; y con la misma indicación que en el caso anterior)

.

Esto nos da 24 horas, que serían el núcleo principal de la enseñanza media. Las otras 11 horas se podrían distribuir de la manera siguiente:

.

- 4 horas de alguna ciencia (saber en qué mundo vives): un año geografía, otro historia, otro biología, otro geología, otro química; naturalmente, el reparto es flexible.

.

- 3 horas de aprendizaje para la vida: nociones sobre el sistema legal y político, reflexión filosófica, vida saludable física y mentalmente, vida laboral, actividades solidarias. A repartir de manera quodlibetal en los diversos cursos.

.

- 4 horas de para el desarrollo físico y cultural: deporte, música, teatro, danza, etc.

.

Las 7 últimas horas podrían incluso suprimirse del currículo "oficial", e "impartirse" (o lo que fuera más conveniente) en horario de tardes en grupos más diversificados y opcionales. Es decir, al final de la secundaria cada alumno tendría que haber hecho un mínimo de actividades de cada tema, pero puede elegirlas como le apetezca.

13 de noviembre de 2012

PROGRESO CIENTÍFICO Y APROXIMACIÓN A LA VERDAD (5)

Recordemos la "reconstrucción" que en la anterior entrada de la serie había propuesto para la noción intuitiva de "grado en el que nos parece que una teoría T se ha aproximado a la verdad, a la luz de los datos empíricos E"

.

.

Bueno, pues vamos con las propiedades. En la próxima (y supongo que última, o penúltima) entrada, comentaré algunas implicaciones más "filosóficas" que también creo que son interesantes.

.

1) La probabilidad de una tautología es siempre igual a 1 (pues p(Taut, E) y P(Taut v E) siempre son 1, sea cual sea E). Nótese que 1 es un valor "bajo", pues Vs puede tener cualquier valor positivo.

.

2) Si los datos E confirman T, entonces Vs(T,E) = 1/p(T). Esto no suele ser una situación habitual: lo corriente es que busquemos teorías que expliquen los datos, y por lo tanto, una teoría T tales que E se siga de ella, no que T se siga de E. Pero podemos considerar que esto se aplica a cada una de las leyes empíricas cuya conjunción es E; lo que nos dice este resultado es que esas leyes serán tanto más valiosas científicamente cuanto menor sea su probabilidad a priori, es decir, cuanto más inesperadas sean.

.

.

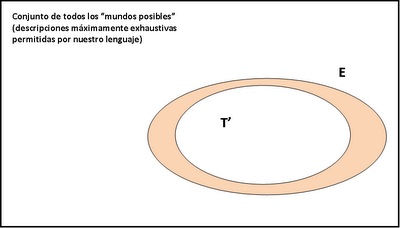

3) Si T explica E (es decir, si E se sigue de T), entonces Vs(T,E) = p(T)/p(E)^2. De aquí se sigue, en primer lugar, que, de dos teorías que consigan explicar E, la que nos parecerá más verosímil es la que es menos implausible a priori. En segundo lugar (o, lo que viene a ser lo mismo), la verosimilitud de una teoría que explica los hechos empíricos es inversamente proporcional a la probabilidad de que E sea verdad y T sea falsa (o sea, p(E&¬T): el área anaranjada en la imagen), o sea, si T está "dentro" de E, entonces cuanto más "espacio" ocupe dentro de E, más verosímil nos parecerá; o sea: cuanto menos espacio quede para teorías que sean incompatibles con E pero que también expliquen E, más verosímil nos parecerá T. Esto puede entenderse como una reconstrucción de la idea de David Deutsch de que las buenas explicaciones son las que resultan "difíciles de variar", pero entendiendo por "variar" la probabilidad de que HAYA algunas otras teorías T' que también expliquen E (probabilidad que es igual al área anaranjada), y no la probabilidad de que NOSOTROS ENCONTREMOS alguna de esas teorías (probabilidad que dependerá de otros factores, no sólo de cómo es el mundo o de cómo nos parece que es). Deutsch creo que confunde ambos sentidos, y eso hace de su explicación del asunto una explicación poco explicativa.

.

Por cierto, este resultado también implica que, para que una teoría T que explica los hechos empíricos E sea mejor que una "explicación tautológica" (cuya verosimilitud, recordemos, era igual a 1), entonces debe cumplirse que p(T,E) > p(E), lo que parece un requisito razonable (es decir, visto al revés, si la probabilidad de que T sea verdadera bajo el supuesto de que E es verdadero, es incluso menor que la probabilidad a priori de que E sea verdadero, entonces es que T es condenadamente mala: es incluso peor que no decir nada).

.

4) Si se confirma una nueva predicción F de la teoría T (es decir, una no incluida en aquellas cuya conjunción es E), entonces su verosimilitud aumenta, es decir, Vs(T,E) < Vs(T,E&F). Esto se cumple tanto si entendemos la "predicción" en el sentido de que T implica F, como en el sentido de que T únicamente implica que, si E es verdad, también es verdad F, como en el sentido de que p(F,T&E) > p(F,T).

.

Una de las propiedades más chorra y que a mí más me gusta es la siguiente:

.

5) Vs(T,E) es siempre menor o igual que 1/p(T) y que 1/p(E). Esta propiedad es importante porque para cada teoría posible, siempre hay un límite a la verosimilitud que puede alcanzar, y para conjunto de datos empíricos, siempre hay un límite a la verosimilitud que pueden conceder a cualquier teoría. Es decir, la ciencia siempre nos presentará situaciones en que lo único que podremos hacer para tener teorías aún más verosímiles que las que tenemos es, o bien inventar teorías cuya plausibilidad a priori sea más baja que la de las teorías anteriores, o bien encontrar nuevos datos empíricos, y generalmente ambas cosas. Esto hace honor a la idea popperiana de que la ciencia es una "búsqueda sin término". Y por otro lado, también nos muestra que la plausibilidad a priori de las teorías (lo "razonables" que nos parezcan, con independencia de los datos empíricos) es un arma de doble filo: según el punto 3 no puede ser muy baja, pero según el punto 5, habrá veces en que tengamos que inventar teorías muy implausibles. ¿Quién dijo que hacer buena ciencia tuviera que ser fácil?

.

6) El valor esperado de la funcion Vs(T,E) es igual a la "razón de probabilidad", p(T,E)/p(T), que a su vez es igual a la "razón de likelihood", p(E,T)/p(E). (Lo siento, pero la prueba de este teorema es un poco larga, y los que tengáis curiosidad la podréis ver en el libro Mentiras a medias, o en este artículo, (pgs., 356-357)). La noción matemática de "valor esperado" es aquí la misma que en el caso de Niiniluoto que vimos en la entrada tercera: cuál es el valor de Vs que esperaríamos en función de la probabilidad que E asigna a cada uno de los mundos posibles que son compatibles con E. Lo que significa este teorema es que la percepción de la verosimilitud de una teoría no es la misma cuando los científicos esperan que haya cambios importantes en E que cuando no lo esperan; en el primer caso, tenderán a considerar más razonable el valor esperado de Vs, mientras que en el segundo, tomarán E como (relativamente) "definitivo", y juzgarán las teorías directamente a través de Vs, no de su valor esperado. El caso es que las "razones" de probabilidad o likelihood son herramientas estadísticas habituales para la comparación de teorías, y el hecho de que nuestro modelo implique que eso ha de ser así es un punto a su favor.

.

7) Puede ocurrir que una teoría T' explique más hechos que otra T, pero parezca menos verosímil que ella. Este resultado tiene en cuenta la versión "c" del sentido de "aproximación" que indicamos en la entrada anterior: considerar la verosimilitud de una teoría como función de su coherencia con algún subconjunto de los hechos conocidos, no necesariamente todos. Esto ocurrirá, naturalmente, si T' explica más hechos Ei que T, pero la plausibilidad a priori de T' es mucho menor que la de T. Esto algo que suele ocurrir en las "revoluciones científicas" según Kuhn: el paradigma "nuevo" tiene menos anomalías que el "viejo", pero los defensores del viejo siguen defendiendo éste porque el paradigma nuevo les parece que hace supuestos intolerablemente implausibles.

.

.

Vs(T,E) = p(T,E)/p(TvE).

.

Como indicaba al final, esta fórmula (que, además, se puede modificar para tener en cuenta el carácter aproximado de E, y el hecho de que está constituída por numerosas regularidades empíricas independientes entre sí) posee propiedades de lo más interesante. Pero antes de enumerarlas, indiquemos cuál es el objetivo principal de tener una definición como ésta: se trata de tener una reconstrucción matemática de los criterios comparativos que nos permiten decir si una teoría nos parece mejor que otra, o si una teoría nos parece en cierto momento mejor o peor que lo que nos parecía antes..

Bueno, pues vamos con las propiedades. En la próxima (y supongo que última, o penúltima) entrada, comentaré algunas implicaciones más "filosóficas" que también creo que son interesantes.

.

1) La probabilidad de una tautología es siempre igual a 1 (pues p(Taut, E) y P(Taut v E) siempre son 1, sea cual sea E). Nótese que 1 es un valor "bajo", pues Vs puede tener cualquier valor positivo.

.

2) Si los datos E confirman T, entonces Vs(T,E) = 1/p(T). Esto no suele ser una situación habitual: lo corriente es que busquemos teorías que expliquen los datos, y por lo tanto, una teoría T tales que E se siga de ella, no que T se siga de E. Pero podemos considerar que esto se aplica a cada una de las leyes empíricas cuya conjunción es E; lo que nos dice este resultado es que esas leyes serán tanto más valiosas científicamente cuanto menor sea su probabilidad a priori, es decir, cuanto más inesperadas sean.

.

.

3) Si T explica E (es decir, si E se sigue de T), entonces Vs(T,E) = p(T)/p(E)^2. De aquí se sigue, en primer lugar, que, de dos teorías que consigan explicar E, la que nos parecerá más verosímil es la que es menos implausible a priori. En segundo lugar (o, lo que viene a ser lo mismo), la verosimilitud de una teoría que explica los hechos empíricos es inversamente proporcional a la probabilidad de que E sea verdad y T sea falsa (o sea, p(E&¬T): el área anaranjada en la imagen), o sea, si T está "dentro" de E, entonces cuanto más "espacio" ocupe dentro de E, más verosímil nos parecerá; o sea: cuanto menos espacio quede para teorías que sean incompatibles con E pero que también expliquen E, más verosímil nos parecerá T. Esto puede entenderse como una reconstrucción de la idea de David Deutsch de que las buenas explicaciones son las que resultan "difíciles de variar", pero entendiendo por "variar" la probabilidad de que HAYA algunas otras teorías T' que también expliquen E (probabilidad que es igual al área anaranjada), y no la probabilidad de que NOSOTROS ENCONTREMOS alguna de esas teorías (probabilidad que dependerá de otros factores, no sólo de cómo es el mundo o de cómo nos parece que es). Deutsch creo que confunde ambos sentidos, y eso hace de su explicación del asunto una explicación poco explicativa.

.

Por cierto, este resultado también implica que, para que una teoría T que explica los hechos empíricos E sea mejor que una "explicación tautológica" (cuya verosimilitud, recordemos, era igual a 1), entonces debe cumplirse que p(T,E) > p(E), lo que parece un requisito razonable (es decir, visto al revés, si la probabilidad de que T sea verdadera bajo el supuesto de que E es verdadero, es incluso menor que la probabilidad a priori de que E sea verdadero, entonces es que T es condenadamente mala: es incluso peor que no decir nada).

.

4) Si se confirma una nueva predicción F de la teoría T (es decir, una no incluida en aquellas cuya conjunción es E), entonces su verosimilitud aumenta, es decir, Vs(T,E) < Vs(T,E&F). Esto se cumple tanto si entendemos la "predicción" en el sentido de que T implica F, como en el sentido de que T únicamente implica que, si E es verdad, también es verdad F, como en el sentido de que p(F,T&E) > p(F,T).

.

Una de las propiedades más chorra y que a mí más me gusta es la siguiente:

.

5) Vs(T,E) es siempre menor o igual que 1/p(T) y que 1/p(E). Esta propiedad es importante porque para cada teoría posible, siempre hay un límite a la verosimilitud que puede alcanzar, y para conjunto de datos empíricos, siempre hay un límite a la verosimilitud que pueden conceder a cualquier teoría. Es decir, la ciencia siempre nos presentará situaciones en que lo único que podremos hacer para tener teorías aún más verosímiles que las que tenemos es, o bien inventar teorías cuya plausibilidad a priori sea más baja que la de las teorías anteriores, o bien encontrar nuevos datos empíricos, y generalmente ambas cosas. Esto hace honor a la idea popperiana de que la ciencia es una "búsqueda sin término". Y por otro lado, también nos muestra que la plausibilidad a priori de las teorías (lo "razonables" que nos parezcan, con independencia de los datos empíricos) es un arma de doble filo: según el punto 3 no puede ser muy baja, pero según el punto 5, habrá veces en que tengamos que inventar teorías muy implausibles. ¿Quién dijo que hacer buena ciencia tuviera que ser fácil?

.

6) El valor esperado de la funcion Vs(T,E) es igual a la "razón de probabilidad", p(T,E)/p(T), que a su vez es igual a la "razón de likelihood", p(E,T)/p(E). (Lo siento, pero la prueba de este teorema es un poco larga, y los que tengáis curiosidad la podréis ver en el libro Mentiras a medias, o en este artículo, (pgs., 356-357)). La noción matemática de "valor esperado" es aquí la misma que en el caso de Niiniluoto que vimos en la entrada tercera: cuál es el valor de Vs que esperaríamos en función de la probabilidad que E asigna a cada uno de los mundos posibles que son compatibles con E. Lo que significa este teorema es que la percepción de la verosimilitud de una teoría no es la misma cuando los científicos esperan que haya cambios importantes en E que cuando no lo esperan; en el primer caso, tenderán a considerar más razonable el valor esperado de Vs, mientras que en el segundo, tomarán E como (relativamente) "definitivo", y juzgarán las teorías directamente a través de Vs, no de su valor esperado. El caso es que las "razones" de probabilidad o likelihood son herramientas estadísticas habituales para la comparación de teorías, y el hecho de que nuestro modelo implique que eso ha de ser así es un punto a su favor.

.

7) Puede ocurrir que una teoría T' explique más hechos que otra T, pero parezca menos verosímil que ella. Este resultado tiene en cuenta la versión "c" del sentido de "aproximación" que indicamos en la entrada anterior: considerar la verosimilitud de una teoría como función de su coherencia con algún subconjunto de los hechos conocidos, no necesariamente todos. Esto ocurrirá, naturalmente, si T' explica más hechos Ei que T, pero la plausibilidad a priori de T' es mucho menor que la de T. Esto algo que suele ocurrir en las "revoluciones científicas" según Kuhn: el paradigma "nuevo" tiene menos anomalías que el "viejo", pero los defensores del viejo siguen defendiendo éste porque el paradigma nuevo les parece que hace supuestos intolerablemente implausibles.

.

10 de noviembre de 2012

PROGRESO CIENTÍFICO Y APROXIMACIÓN A LA VERDAD (4)

La serie de entradas sobre el concepto de verosimilitud llega a su fase "culminante", en la que expondré la concepción que he venido desarrollando. Recapacitemos algunas cuestiones importantes, que nuestro enfoque tendrá que tener en cuenta inevitablemente:

.

1) la noción de semejanza es relativamente subjetiva: dos cosas pueden ser parecidas para un sujeto, o desde cierto punto de vista, o en función de ciertos intereses, pero no ser tan parecidas en otros casos;

.

2) pese a ello, pretendemos identificar algún concepto razonable de "aproximación a la verdad" según el cual tenga sentido la afirmación de que el objetivo de la ciencia es aproximarnos a la verdad; y

.

3) este concepto debería poder ponerse en conexión con las normas y criterios metodológicos usados por los científicos, de tal modo que podamos explicar que la razón por la que se siguen aquellas normas es porque haciéndolo así es de esperar que consigamos teorías que estén más próximas a la verdad que siguiendo otras normas.

.

Pues bien, mi sugerencia es hacer la suposición de que el grado (subjetivo) de semejanza entre dos proposiciones, A y B, depende principalmente de tres factores:

.

a) la coherencia entre A y B, que puede ser medida con la fórmula p(A&B)/p(AvB) = p(A&B,AvB); o sea, la probabilidad que el sujeto atribuye a la posibilidad de que A y B sean verdaderas las dos, dividida por la probabilidad de que sea verdadera alguna de las dos (lo cual equivale a la probabilidad de que las dos sean verdadera condicionada a que al menos una de ellas lo es); gráficamente esto corresponde al área comprendida en la intersección de los conjuntos de mundos que corresponden a ambas teorías, dividida por el área de la unión de ambos conjuntos;

.

b) al factor anterior, que considero el principal, añadimos otros dos; en primer lugar, tanto A como B pueden "emborronarse", en el sentido de sustituir B (p.ej.) por la proposición B(d), que afirma que "el mundo verdadero está a una distancia menor que d de algún mundo permitido por B"; es decir, consideramos que B no nos da una descripción "exacta" del mundo, sino "aproximada" (con grado de aproximación igual a d; recordar la entrada número 2 de la serie); una vez hecho esto, aplicamos la noción definida en el párrafo anterior, pero en vez de entre A y B, lo hacemos entre A y B(d); esto nos sugeriría definir la semejanza entre A y B como igual a p(A&B(d)/AvB(d)), eligiendo d de tal manera que el valor de esa fracción sea el máximo posible.

.

c) por último, también podemos tener en cuenta que los enunciados A o B pueden consistir en la conjunción de varios enunciados que, por las razones que sean, consideremos proposiciones independientes entre sí y relevantes para juzgar la semejanza entre las primeras; si, p.ej., B es la conjunción de varios enunciados, B1, B2, ..., Bn, podemos considerar que la semejanza entre A y B equivale al resultado de aplicar la medida de semejanza basada en la coherencia a alguna de las combinaciones de los enunciados B1, ..., Bn, en concreto, a aquella combinación cuya coherencia con A sea mayor.

.

Los criterios b y c permiten establecer que dos enunciados A y B pueden ser semejantes incluso aunque sean lógicamente contradictorios entre sí (y por lo tanto, p(A&B) sea igual a 0): si A es incompatible con B, pero no es incompatible con B(d), o no es incompatible con muchos de los enunciados Bi cuya conjunción forma B, entonces es posible que A nos parezca pese a todo bastante semejante a B. También es importante señalar que los criterios b y c pueden aplicarse a la vez: A puede parecernos semejante a B por ser coherente con algunos Bi expresados éstos en versión no exacta sino aproximada (Bi(d)).

.

Teniendo esto en mente, ¿cómo podríamos definir el "grado de aproximación a la verdad" de una teoría T? Si V representa la verdad más completa que podemos expresar con el lenguaje del que disponemos (o sea, la proposición que describe el "mundo verdadero" de la figura), una posibilidad sería p(T&V(d))/p(TvV(d)) (con la distancia d para la que esto es máximo). Otra posibilidad sería considerar a qué conjunción de proposiciones equivale V y aplicar el criterio c. La solución que me parece más prometedora es utilizar, para la determinación del grado en el que nos parece que T se ha aproximado a la verdad, la proposición que nos dice, precisamente, qué es lo que sabemos sobre la verdad: nuestros "datos empíricos" E, que generalmente consistirán en la conjunción de aquellas regularidades empíricas que las teorías deben "explicar". Mi definición favorita es, por tanto, la siguiente:

.

.

Puesto que, por definición, estamos suponiendo que los datos empíricos son verdaderos (son los que aceptamos como verdadero sobre la verdad), entonces la definición se reduce a lo siguiente:

.

Puesto que la probabilidad de V es una constante (será siempre la misma, sean cuales sean T y E), y puesto que lo que queremos es una función que nos sirva para comparar la verosimilitud de dos teorías frente a los mismos datos, o de una teoría frente a un conjunto cambiante de datos, etc., podemos suprimir la referencia a p(V) (que aparecerá en todas las comparaciones del tipo Vs(T,E) > Vs(T',E') a los dos lados de la comparación, y podremos borrarla en los dos lados), y la definición se nos queda asín:

.

A esa definición le podremos aplicar posteriormente los criterios b y c cuando sea menester.

.

En la próxima entrada empezaré a comentar las (fantásticas) propiedades de esta función.

.

.

1) la noción de semejanza es relativamente subjetiva: dos cosas pueden ser parecidas para un sujeto, o desde cierto punto de vista, o en función de ciertos intereses, pero no ser tan parecidas en otros casos;

.

2) pese a ello, pretendemos identificar algún concepto razonable de "aproximación a la verdad" según el cual tenga sentido la afirmación de que el objetivo de la ciencia es aproximarnos a la verdad; y

.

3) este concepto debería poder ponerse en conexión con las normas y criterios metodológicos usados por los científicos, de tal modo que podamos explicar que la razón por la que se siguen aquellas normas es porque haciéndolo así es de esperar que consigamos teorías que estén más próximas a la verdad que siguiendo otras normas.

.

Pues bien, mi sugerencia es hacer la suposición de que el grado (subjetivo) de semejanza entre dos proposiciones, A y B, depende principalmente de tres factores:

.

a) la coherencia entre A y B, que puede ser medida con la fórmula p(A&B)/p(AvB) = p(A&B,AvB); o sea, la probabilidad que el sujeto atribuye a la posibilidad de que A y B sean verdaderas las dos, dividida por la probabilidad de que sea verdadera alguna de las dos (lo cual equivale a la probabilidad de que las dos sean verdadera condicionada a que al menos una de ellas lo es); gráficamente esto corresponde al área comprendida en la intersección de los conjuntos de mundos que corresponden a ambas teorías, dividida por el área de la unión de ambos conjuntos;

.

b) al factor anterior, que considero el principal, añadimos otros dos; en primer lugar, tanto A como B pueden "emborronarse", en el sentido de sustituir B (p.ej.) por la proposición B(d), que afirma que "el mundo verdadero está a una distancia menor que d de algún mundo permitido por B"; es decir, consideramos que B no nos da una descripción "exacta" del mundo, sino "aproximada" (con grado de aproximación igual a d; recordar la entrada número 2 de la serie); una vez hecho esto, aplicamos la noción definida en el párrafo anterior, pero en vez de entre A y B, lo hacemos entre A y B(d); esto nos sugeriría definir la semejanza entre A y B como igual a p(A&B(d)/AvB(d)), eligiendo d de tal manera que el valor de esa fracción sea el máximo posible.

.

c) por último, también podemos tener en cuenta que los enunciados A o B pueden consistir en la conjunción de varios enunciados que, por las razones que sean, consideremos proposiciones independientes entre sí y relevantes para juzgar la semejanza entre las primeras; si, p.ej., B es la conjunción de varios enunciados, B1, B2, ..., Bn, podemos considerar que la semejanza entre A y B equivale al resultado de aplicar la medida de semejanza basada en la coherencia a alguna de las combinaciones de los enunciados B1, ..., Bn, en concreto, a aquella combinación cuya coherencia con A sea mayor.

.

Los criterios b y c permiten establecer que dos enunciados A y B pueden ser semejantes incluso aunque sean lógicamente contradictorios entre sí (y por lo tanto, p(A&B) sea igual a 0): si A es incompatible con B, pero no es incompatible con B(d), o no es incompatible con muchos de los enunciados Bi cuya conjunción forma B, entonces es posible que A nos parezca pese a todo bastante semejante a B. También es importante señalar que los criterios b y c pueden aplicarse a la vez: A puede parecernos semejante a B por ser coherente con algunos Bi expresados éstos en versión no exacta sino aproximada (Bi(d)).

.

Teniendo esto en mente, ¿cómo podríamos definir el "grado de aproximación a la verdad" de una teoría T? Si V representa la verdad más completa que podemos expresar con el lenguaje del que disponemos (o sea, la proposición que describe el "mundo verdadero" de la figura), una posibilidad sería p(T&V(d))/p(TvV(d)) (con la distancia d para la que esto es máximo). Otra posibilidad sería considerar a qué conjunción de proposiciones equivale V y aplicar el criterio c. La solución que me parece más prometedora es utilizar, para la determinación del grado en el que nos parece que T se ha aproximado a la verdad, la proposición que nos dice, precisamente, qué es lo que sabemos sobre la verdad: nuestros "datos empíricos" E, que generalmente consistirán en la conjunción de aquellas regularidades empíricas que las teorías deben "explicar". Mi definición favorita es, por tanto, la siguiente:

.

Vs(T,E) = Semejanza entre T y E * Semejanza entre E y V.

.

Es decir, la verosimilitud de una teoría T, a la luz de los datos empíricos que poseemos, vendrá dada por la semejanza que hay entre la teoría T y los datos E, ponderada por la semejanza que hay entre E y la "verdad completa", V (pues, cuanto más próxima esté E a V, más verosímil nos parecerá una teoría que sea coherente con esos datos)..

Puesto que, por definición, estamos suponiendo que los datos empíricos son verdaderos (son los que aceptamos como verdadero sobre la verdad), entonces la definición se reduce a lo siguiente:

.

Vs(T,E) = [p(T&E)/p(TvE)][p(T&E)/p(TvE)]

.

= [p(T&E)/p(TvE)][p(V)/p(E)]

.

= [p(T&E)/p(E)][p(V)/p(TvE)]

.

= [p(T,E)/p(TvE)]p(V)

.Puesto que la probabilidad de V es una constante (será siempre la misma, sean cuales sean T y E), y puesto que lo que queremos es una función que nos sirva para comparar la verosimilitud de dos teorías frente a los mismos datos, o de una teoría frente a un conjunto cambiante de datos, etc., podemos suprimir la referencia a p(V) (que aparecerá en todas las comparaciones del tipo Vs(T,E) > Vs(T',E') a los dos lados de la comparación, y podremos borrarla en los dos lados), y la definición se nos queda asín:

.

Vs(T,E) = p(T,E)/p(TvE).

.A esa definición le podremos aplicar posteriormente los criterios b y c cuando sea menester.

.

En la próxima entrada empezaré a comentar las (fantásticas) propiedades de esta función.

.

8 de noviembre de 2012

PERIODISMO Y COMUNICACIÓN CIENTÍFICA EN LA UNED: ABIERTA LA MATRÍCULA HASTA EL 27 DE NOVIEMBRE

Hasta el próximo 27 de noviembre, estará abierto el plazo de inscripción en la 8ª edición del Programa Modular "Periodismo Científico y Comunicación Científica", de la UNED, para el curso 2012-2013, un programa del que muchos ya sabéis que soy el coordinador. Podéis encontrar la información sobre el curso aquí.

DE REIVINDICACIONES

"Nunca he podido entender por qué las clases medias de este país aceptan que a sus hijos les estafen al no concederles estas herramientas básicas para avanzar en el mundo actual. Esa reivindicación, que enseñen a mis hijos muchas matemáticas y a escribir en español con convicción y con capacidad de hacer un análisis complejo y a hablar inglés, y bien, debería ser la más importante en los coles y no las cosas de las comidas, los túpers y la limpieza del cole (a mi me toca limpiar la clase de mis hijos una vez al año porque no hay dinero para servicio de limpieza, y nos turnamos los padres). Y si hay que recortar sanidad, pensiones o lo que haga falta para tener unas escuelas capaces de poner a nuestros hijos al nivel requerido para ese mundo en el que van a participar, pues que así sea. La educación debe ser la prioridad. Yo esa reivindicación no la oigo, ¿vosotros?"

"Nunca he podido entender por qué las clases medias de este país aceptan que a sus hijos les estafen al no concederles estas herramientas básicas para avanzar en el mundo actual. Esa reivindicación, que enseñen a mis hijos muchas matemáticas y a escribir en español con convicción y con capacidad de hacer un análisis complejo y a hablar inglés, y bien, debería ser la más importante en los coles y no las cosas de las comidas, los túpers y la limpieza del cole (a mi me toca limpiar la clase de mis hijos una vez al año porque no hay dinero para servicio de limpieza, y nos turnamos los padres). Y si hay que recortar sanidad, pensiones o lo que haga falta para tener unas escuelas capaces de poner a nuestros hijos al nivel requerido para ese mundo en el que van a participar, pues que así sea. La educación debe ser la prioridad. Yo esa reivindicación no la oigo, ¿vosotros?"Luis Garicano, en Nada es Gratis.

7 de noviembre de 2012

PROGRESO CIENTÍFICO Y APROXIMACIÓN A LA VERDAD (3)

Resumiendo la entrada anterior sobre el tema de la verosimilitud: si consideramos el conjunto de los "mundos posibles" (es decir, las descripciones más exhaustivas posibles permitidas por el lenguaje con el que intentamos describir el mundo), habrá una (y una sola) de esas descripciones que sea verdadera, mientras que las demás son falsas; si consideramos una medida de "distancia" o "desemejanza" entre descripciones exhaustivas distintas, podemos entonces definir la "distancia a la verdad" de una teoría T como una función de las distancias que hay entre el "mundo verdadero" y cada uno de los "mundos" compatible con T (pues T puede considerarse equivalente al conjunto de esos mundos, aquellos que, si fueran verdaderos, harían verdadera la teoría T).

.

Este enfoque se enfrenta, de todas formas a dos problemas bastante serios:

.

1) ¿Hay alguna medida de "semejanza (o distancia) entre mundos" que sea "objetiva"; todos sabemos que los abuelos paternos siempre encuentran a los recién nacidos más parecidos al padre que a la madre, mientras que para los abuelos maternos es justo al revés. "Cuánto se parecen dos descripciones del mundo" ¿no es, en el fondo, una cuestión bastante subjetiva? Los defensores del enfoque de la similaridad argumentan que, en efecto, hasta cierto punto la semejanza entre descripciones es subjetiva, pero al fin y al cabo, lo que queremos es aproximarnos nosotros a la verdad, y por lo tanto, lo importante serán las relaciones de semejanza que a nosotros nos parezcan relevantes. El concepto de "verosimilitud" (semejanza a la verdad) será, por tanto, un concepto relativamente subjetivo. Una comunidad científica con valores epistémicos algo diferentes de los nuestros, y por lo tanto criterios de semejanza entre teorías o descripciones también algo distintos de los nuestros, podrá, tal vez, preferir teorías distintas a las que preferimos nosotros porque a ellos le parecen "más semejantes a la verdad", pero eso no contradice la tesis de que tanto ellos como nosotros valoramos las teorías científicas en función de cuánto pensamos que se han acercado a la verdad.

.

2) Un problema mucho más serio es el siguiente: una vez que hemos definido el grado de verosimilitud de una teoría T en función de la distancia que hay entre el "mundo verdadero" y los "mundos" compatibles con T, ¿qué carajo podemos hacer para averiguar cuál es el grado de verosimilitud de cada teoría, o para saber si una teoría es más o menos verosímil que otra, si precisamente no sabemos cuál es el mundo verdadero? (si lo supiéramos, ¿para qué querríamos las "teorías"?).

2) Un problema mucho más serio es el siguiente: una vez que hemos definido el grado de verosimilitud de una teoría T en función de la distancia que hay entre el "mundo verdadero" y los "mundos" compatibles con T, ¿qué carajo podemos hacer para averiguar cuál es el grado de verosimilitud de cada teoría, o para saber si una teoría es más o menos verosímil que otra, si precisamente no sabemos cuál es el mundo verdadero? (si lo supiéramos, ¿para qué querríamos las "teorías"?).

.

El filósofo finlandés Ilkka Niiniluoto propuso una respuesta ingeniosa: nuestros datos empíricos no nos dicen cuál de todos los "mundos posibles" es el verdadero, pero sí que nos pueden servir para determinar una distribución de probabilidad entre todos los mundos; es decir, dados nuestros datos empíricos, ¿qué probabilidad tiene el mundo m de ser el verdadero?; digamos, p(m/e). Combinando esta noción con la de distancia entre mundos, podemos definir fácilmente el "grado estimado de verosimilitud de una teoría T"; este grado será, sencillamente, el valor estadísticamente esperado de la verosimilitud de T, dada la distribución empírica de probabilidad de todos los mundos. Técnicamente,:

Es decir, la verosimilitud estimada de T, sobre la base de los datos empíricos e, es la suma, para todos los mundos posibles m, de la verosimilitud que tendría T si m fuera el mundo verdadero, ponderado cada sumando por la probabilidad de que m sea el mundo verdadero dados los datos empíricos e.

.

Por desgracia, aunque esto puede aclarar conceptualmente la diferencia entre el grado de semejanza-subjetiva "real" entre una teoría T y la verdad, por un lado, y el grado de semejanza-subjetiva "aparente" de la teoría T, el caso es que, en la práctica, no se ha propuesto ninguna forma en la que podamos, no ya calcular el valor de EVs(T,e), sino tener alguna idea de si, de hecho, los datos empíricos nos van mostrando si nuestras teorías se alejan o se acercan a la verdad. Es decir, no hay ninguna forma conocida de conectar la definición de EVs(T,e) con las normas para determinar cuándo tenemos que preferir una teoría científica a otra.

.

En la próxima entrada empezaré a contar mi propio enfoque sobre la cuestión.

.

.

Más:

Progreso científico y aproximación a la verdad (1)

Progreso científico y aproximación a la verdad (2)

.

Este enfoque se enfrenta, de todas formas a dos problemas bastante serios:

.

1) ¿Hay alguna medida de "semejanza (o distancia) entre mundos" que sea "objetiva"; todos sabemos que los abuelos paternos siempre encuentran a los recién nacidos más parecidos al padre que a la madre, mientras que para los abuelos maternos es justo al revés. "Cuánto se parecen dos descripciones del mundo" ¿no es, en el fondo, una cuestión bastante subjetiva? Los defensores del enfoque de la similaridad argumentan que, en efecto, hasta cierto punto la semejanza entre descripciones es subjetiva, pero al fin y al cabo, lo que queremos es aproximarnos nosotros a la verdad, y por lo tanto, lo importante serán las relaciones de semejanza que a nosotros nos parezcan relevantes. El concepto de "verosimilitud" (semejanza a la verdad) será, por tanto, un concepto relativamente subjetivo. Una comunidad científica con valores epistémicos algo diferentes de los nuestros, y por lo tanto criterios de semejanza entre teorías o descripciones también algo distintos de los nuestros, podrá, tal vez, preferir teorías distintas a las que preferimos nosotros porque a ellos le parecen "más semejantes a la verdad", pero eso no contradice la tesis de que tanto ellos como nosotros valoramos las teorías científicas en función de cuánto pensamos que se han acercado a la verdad.

.

2) Un problema mucho más serio es el siguiente: una vez que hemos definido el grado de verosimilitud de una teoría T en función de la distancia que hay entre el "mundo verdadero" y los "mundos" compatibles con T, ¿qué carajo podemos hacer para averiguar cuál es el grado de verosimilitud de cada teoría, o para saber si una teoría es más o menos verosímil que otra, si precisamente no sabemos cuál es el mundo verdadero? (si lo supiéramos, ¿para qué querríamos las "teorías"?).

2) Un problema mucho más serio es el siguiente: una vez que hemos definido el grado de verosimilitud de una teoría T en función de la distancia que hay entre el "mundo verdadero" y los "mundos" compatibles con T, ¿qué carajo podemos hacer para averiguar cuál es el grado de verosimilitud de cada teoría, o para saber si una teoría es más o menos verosímil que otra, si precisamente no sabemos cuál es el mundo verdadero? (si lo supiéramos, ¿para qué querríamos las "teorías"?)..

El filósofo finlandés Ilkka Niiniluoto propuso una respuesta ingeniosa: nuestros datos empíricos no nos dicen cuál de todos los "mundos posibles" es el verdadero, pero sí que nos pueden servir para determinar una distribución de probabilidad entre todos los mundos; es decir, dados nuestros datos empíricos, ¿qué probabilidad tiene el mundo m de ser el verdadero?; digamos, p(m/e). Combinando esta noción con la de distancia entre mundos, podemos definir fácilmente el "grado estimado de verosimilitud de una teoría T"; este grado será, sencillamente, el valor estadísticamente esperado de la verosimilitud de T, dada la distribución empírica de probabilidad de todos los mundos. Técnicamente,:

EVs(T,e) = Σm Vs(T,m)p(m,e)

Es decir, la verosimilitud estimada de T, sobre la base de los datos empíricos e, es la suma, para todos los mundos posibles m, de la verosimilitud que tendría T si m fuera el mundo verdadero, ponderado cada sumando por la probabilidad de que m sea el mundo verdadero dados los datos empíricos e.

.

Por desgracia, aunque esto puede aclarar conceptualmente la diferencia entre el grado de semejanza-subjetiva "real" entre una teoría T y la verdad, por un lado, y el grado de semejanza-subjetiva "aparente" de la teoría T, el caso es que, en la práctica, no se ha propuesto ninguna forma en la que podamos, no ya calcular el valor de EVs(T,e), sino tener alguna idea de si, de hecho, los datos empíricos nos van mostrando si nuestras teorías se alejan o se acercan a la verdad. Es decir, no hay ninguna forma conocida de conectar la definición de EVs(T,e) con las normas para determinar cuándo tenemos que preferir una teoría científica a otra.

.

En la próxima entrada empezaré a contar mi propio enfoque sobre la cuestión.

.

.

Más:

Progreso científico y aproximación a la verdad (1)

Progreso científico y aproximación a la verdad (2)

CADA UNO VE LA FERIA SEGÚN LE VA CON LA BOTELLA

Ejercicio de periodismo ficción: imaginar lo que estaría pasando estos días en los troglomedios si en Madrid tuviéramos un alcalde de izquierdas.

.

Aunque no me extrañaría que un sector del PP ya esté empezando a ver la botella medio vacía.

.

Aunque no me extrañaría que un sector del PP ya esté empezando a ver la botella medio vacía.

6 de noviembre de 2012

EL "TOP TEN" DE MI LISTA DE LECTURAS

Os selecciono aquí los 10 libros más recomendables de los primeros 200 que he echado al buche desde que comenzó la lista hace casi tres años:

.

.

NOVELA

El último encuentro, Sandor Marai.

Yo confieso, Jordi Cabré.

Crimen y castigo, Fedor Dostoievski.

Trilogía Africanus, Santiago Posteguillo.

Rapsodia gourmet, Muriel Barbery.

.

ENSAYO

El optimista racional, Mat Ridley.

The better angels of our nature, Stephen Pinker.

Los tres jinetes del cambio climático, William Rudiman.

Jesus, interrupted, Bart Ehrman.

Mal de escuela, Daniel Pennac.

.

.NOVELA

El último encuentro, Sandor Marai.

Yo confieso, Jordi Cabré.

Crimen y castigo, Fedor Dostoievski.

Trilogía Africanus, Santiago Posteguillo.

Rapsodia gourmet, Muriel Barbery.

.

ENSAYO

El optimista racional, Mat Ridley.

The better angels of our nature, Stephen Pinker.

Los tres jinetes del cambio climático, William Rudiman.

Jesus, interrupted, Bart Ehrman.

Mal de escuela, Daniel Pennac.

5 de noviembre de 2012

PROGRESO CIENTÍFICO Y APROXIMACIÓN A LA VERDAD (2)

Seguimos aquí con la cuestión de la verosimilitud (o aproximación a la verdad) tal como lo dejamos el otro día. En resumen, la definición de verosimilitud que ofreció Popper se vio que era inútil (pues, como mostró Tichy, no podía haber una teoría falsa que fuera más verosímil que otra teoría, con independencia de si la segunda era falsa o verdadera, y recordemos que lo que pretendía Popper con su concepto de verosimilitud era poder afirmar que de dos teorías falsas, una de ellas es más próxima a la verdad que otra).

.

Ante esta situación, hubo dos grupos de reacciones, principalmente, a las que se ha llamado "el enfoque consecuencial" y "el enfoque de la similaridad", respectivamente.

.

Los autores enmarcados en el enfoque consecuencial intentan mantener la definición de Popper, pero restringiendo su aplicación de alguna manera que permita impedir que se le aplique la prueba de Tichy. Recordemos que la definición de Popper viene a decir (más o menos) que una teoría A es más verosímil que otra teoría B si y sólo si la primera tiene todos los "aciertos" de la segunda, y la segunda tiene todos los "fallos" de la primera. Una sugerencia obvia consistiría en considerar que no todos los enunciados que se siguen de A o de B serían relevantes para esta comparación. El problema, obviamente, es que no hay un modo unívoco, lógico, justificable a priori, etc., etc., mediante el que distinguir las consecuencias relevantes de las irrelevantes, y por ello este enfoque, aunque ha sido defendido como digo por algunos autores, no ha sido el más popular. El filósofo austriaco Paul Weingartner ha sido posiblemente el principal. Como se verá en las siguientes entradas, mi propia propuesta sirve para rescatar parte de esta idea, aunque también de la que veremos a continuación.

.

La otra opción, en las obras sobre el tema, ha sido olvidarse de la definición de Popper y buscar una "idea subyacente" distinta. En lugar de considerar, como hacíamos en el dibujo de la entrada anterior, el conjunto de todos los enunciados que pueden expresarse en un lenguaje, ahora nos restringimos en principio sólo a los enunciados máximamente informativos o "exhaustivos" que pueden expresarse en el lenguaje en cuestión (L). Cada uno de estos enunciados representaría, metafóricamente hablando, un "mundo posible", una de las formas como el mundo podría ser si hubiera que describirlo sólo mediante los recursos expresivos del lenguaje L. Los autores englobados en el "enfoque de la similaridad" sacan partido de la idea de que estos "mundos posibles" serán más o menos parecidos entre sí, o, dicho de otro modo, habrá alguna posible medida de "distancia" (o "distancia lógica") entre cada par de mundos posibles.

.

De todos los "mundos posibles" (o sea, las descripciones máximamente informativas del mundo que se pueden expresar utilizando el lenguaje L), sólo uno sera "el mundo verdadero" (el punto verde del dibujo): todos los demás "mundos" serán falsos. Pero habrá mundos que estén más próximos al mundo verdadero que otros, y el objetivo de un proceso de investigación científica será "aproximarnos tanto como sea posible" a ese mundo verdadero.

.

Ahora bien, esto tiene sus problemillas: primero, una teoría científica no es un enunciado "máximamente informativo, exhaustivo", sino que suele ser un enunciado que dice "el mundo tiene tales y cuales propiedades", y generalmente siempre hay muchos mundos posibles que tienen esas propiedades. Podemos identificar, por tanto, una teoría T con el conjunto de mundos posibles (descriptibles con el lenguaje en el que se expresa T) que son como dice T que es el mundo verdadero; llamemos M(T) a ese conjunto de mundos. Una teoría será verdadera justo si coincide que el mundo verdadero es uno de los mundos que pertenecen a M(T). Una teoría será falsa si el mundo verdadero no es como ella dice que es, o sea, si el mundo verdadero NO pertenece a M(T).

.

La cuestión es que aunque tengamos una medida de distancia D entre mundos que nos dice cómo de alejados están unos mundos de otros, esto no nos permite responder inmediatamente a la pregunta "¿cómo es una teoría T de aproximadamente verdadera?". Aquí, los defensores del enfoque de la similaridad sugirieron varias posibilidades, pero sin un criterio lógico muy definido para elegir entre ellas. P.ej.

.

a) el grado de verosimilitud de una teoría T equivale a la semejanza entre el mundo verdadero y ALGUNO de los mundos incluidos en M(T), o sea, la distancia de T a la verdad sería la distancia MÍNIMA entre sus mundos y el mundo verdadero (pero esto lleva a la conclusión de que todas las teorías verdaderas tendrían el máximo grado posible de verosimilitud, y parece que nos gustaría pensar que ALGUNAS teorías falsas -p.ej., la mecánica de Newton- son más verosímiles, o sea, nos han aproximado más a la verdad COMPLETA sobre el mundo, que ALGUNOS enunciados verdaderos -p.ej., el enunciado "la Luna gira alrededor de la Tierra"-).

.

b) la distancia de T a la verdad podría definirse como la DISTANCIA MEDIA entre sus mundos y el mundo verdadero (esto es un poco mejor, pero aún no del todo satisfactorio: al fin y al cabo, queremos teorías que tengan un M(T) pequeño, es decir, que nos den mucha información sobre el mundo)

.

c) alguna combinación entre la distancia media entre M(T) y el mundo verdadero y el tamaño de M(T) (pero esto es un poco arbitrario, porque ambas medidas -distancia y tamaño- son heterogéneas).

.

En la próxima entrada veremos más problemas sobre este enfoque.

.

.

Progreso científico y aproximación a la verdad (3)

.

Progreso científico y aproximación a la verdad (1)

.

.

Ante esta situación, hubo dos grupos de reacciones, principalmente, a las que se ha llamado "el enfoque consecuencial" y "el enfoque de la similaridad", respectivamente.

.

Los autores enmarcados en el enfoque consecuencial intentan mantener la definición de Popper, pero restringiendo su aplicación de alguna manera que permita impedir que se le aplique la prueba de Tichy. Recordemos que la definición de Popper viene a decir (más o menos) que una teoría A es más verosímil que otra teoría B si y sólo si la primera tiene todos los "aciertos" de la segunda, y la segunda tiene todos los "fallos" de la primera. Una sugerencia obvia consistiría en considerar que no todos los enunciados que se siguen de A o de B serían relevantes para esta comparación. El problema, obviamente, es que no hay un modo unívoco, lógico, justificable a priori, etc., etc., mediante el que distinguir las consecuencias relevantes de las irrelevantes, y por ello este enfoque, aunque ha sido defendido como digo por algunos autores, no ha sido el más popular. El filósofo austriaco Paul Weingartner ha sido posiblemente el principal. Como se verá en las siguientes entradas, mi propia propuesta sirve para rescatar parte de esta idea, aunque también de la que veremos a continuación.

.

La otra opción, en las obras sobre el tema, ha sido olvidarse de la definición de Popper y buscar una "idea subyacente" distinta. En lugar de considerar, como hacíamos en el dibujo de la entrada anterior, el conjunto de todos los enunciados que pueden expresarse en un lenguaje, ahora nos restringimos en principio sólo a los enunciados máximamente informativos o "exhaustivos" que pueden expresarse en el lenguaje en cuestión (L). Cada uno de estos enunciados representaría, metafóricamente hablando, un "mundo posible", una de las formas como el mundo podría ser si hubiera que describirlo sólo mediante los recursos expresivos del lenguaje L. Los autores englobados en el "enfoque de la similaridad" sacan partido de la idea de que estos "mundos posibles" serán más o menos parecidos entre sí, o, dicho de otro modo, habrá alguna posible medida de "distancia" (o "distancia lógica") entre cada par de mundos posibles.

.

De todos los "mundos posibles" (o sea, las descripciones máximamente informativas del mundo que se pueden expresar utilizando el lenguaje L), sólo uno sera "el mundo verdadero" (el punto verde del dibujo): todos los demás "mundos" serán falsos. Pero habrá mundos que estén más próximos al mundo verdadero que otros, y el objetivo de un proceso de investigación científica será "aproximarnos tanto como sea posible" a ese mundo verdadero.

.

Ahora bien, esto tiene sus problemillas: primero, una teoría científica no es un enunciado "máximamente informativo, exhaustivo", sino que suele ser un enunciado que dice "el mundo tiene tales y cuales propiedades", y generalmente siempre hay muchos mundos posibles que tienen esas propiedades. Podemos identificar, por tanto, una teoría T con el conjunto de mundos posibles (descriptibles con el lenguaje en el que se expresa T) que son como dice T que es el mundo verdadero; llamemos M(T) a ese conjunto de mundos. Una teoría será verdadera justo si coincide que el mundo verdadero es uno de los mundos que pertenecen a M(T). Una teoría será falsa si el mundo verdadero no es como ella dice que es, o sea, si el mundo verdadero NO pertenece a M(T).

.

La cuestión es que aunque tengamos una medida de distancia D entre mundos que nos dice cómo de alejados están unos mundos de otros, esto no nos permite responder inmediatamente a la pregunta "¿cómo es una teoría T de aproximadamente verdadera?". Aquí, los defensores del enfoque de la similaridad sugirieron varias posibilidades, pero sin un criterio lógico muy definido para elegir entre ellas. P.ej.

.

a) el grado de verosimilitud de una teoría T equivale a la semejanza entre el mundo verdadero y ALGUNO de los mundos incluidos en M(T), o sea, la distancia de T a la verdad sería la distancia MÍNIMA entre sus mundos y el mundo verdadero (pero esto lleva a la conclusión de que todas las teorías verdaderas tendrían el máximo grado posible de verosimilitud, y parece que nos gustaría pensar que ALGUNAS teorías falsas -p.ej., la mecánica de Newton- son más verosímiles, o sea, nos han aproximado más a la verdad COMPLETA sobre el mundo, que ALGUNOS enunciados verdaderos -p.ej., el enunciado "la Luna gira alrededor de la Tierra"-).

.

b) la distancia de T a la verdad podría definirse como la DISTANCIA MEDIA entre sus mundos y el mundo verdadero (esto es un poco mejor, pero aún no del todo satisfactorio: al fin y al cabo, queremos teorías que tengan un M(T) pequeño, es decir, que nos den mucha información sobre el mundo)

.

c) alguna combinación entre la distancia media entre M(T) y el mundo verdadero y el tamaño de M(T) (pero esto es un poco arbitrario, porque ambas medidas -distancia y tamaño- son heterogéneas).

.

En la próxima entrada veremos más problemas sobre este enfoque.

.

.

Progreso científico y aproximación a la verdad (3)

.

Progreso científico y aproximación a la verdad (1)

.

2 de noviembre de 2012

PROGRESO CIENTÍFICO Y APROXIMACIÓN A LA VERDAD

Abro con esta entrada una serie sobre la noción de "verosimilitud" en filosofía de la ciencia (que ya me vale, después de 5 años de blog). Ya sabéis que todo lo que hay que saber sobre este tema se puede aprender en el libro Mentiras a medias, que me podéis pedir gratuitamente enviándome vuestra dirección a mi correo de la uned (jpzb [-arrobita-] fsof.uned.es).

.

Sabemos, al menos desde Karl Popper, que el progreso científico no consiste, al menos no meramente, en una "acumulación de verdades", sino más bien en la sustitución de unas teorías por otras, cuando las primeras son refutadas por nuevos descubrimientos empíricos. Parece que el destino de todas o casi todas las teorías científicas "importantes" es el de acabar siendo descartadas y reemplazadas por otras teorías "mejores". La cuestión es que Popper era un filósofo realista: pensaba que el objetivo de la ciencia es la verdad, y que precisamente la razón para abandonar una teoría refutada era que la refutación equivalía a mostrar que la teoría era falsa. Pero, si todas las teorías científicas "serias" serán tarde o temprano refutadas, eso significa que todas esas teorías son, en el fondo, falsas... ¿y qué ganamos entonces al sustituir una teoría que hemos mostrado que es falsa por otra teoría que resulta que es falsa también? Nótese que para un instrumentalista esto no es un problema: las teorías "nuevas" pueden ser "mejores" en el sentido de que nos permiten calcular predicciones más exactas, p.ej., y no importa si las teorías mismas sean falsas; pero, como digo, Popper era realista, no consideraba que lo que hace que una teoría sea mejor o peor consista sólo en que sus predicciones son mejores.

.

Para responder a esta cuestión, Popper propuso el concepto de verosimilitud: dos teorías falsas pueden diferenciarse en que una de ellas está "más próxima a la verdad" que la otra. El objetivo de la ciencia para un realista podría consistir, pues, en encontrar teorías que estén "cada vez más próximas a la verdad", que sean cada vez más "verosímiles" (en este sentido especial).

.

Popper sugirió una definición más técnica del concepto de verosimilitud: la teoría A es más verosímil que la teoría B si (y sólo si) todas las consecuencias verdaderas de B son consecuencias de A, y todas las consecuencias falsas de A son consecuencias de B, y además A tiene alguna consecuencia verdadera que no tiene B, o B alguna consecuencia falsa que no tiene A. Dicho de otro modo: A es más verosímil que B si (y sólo si) A tiene todos los "aciertos" de B y B tiene todos los "fallos" de A. La imagen siguiente muestra esa relación, donde cada teoría, A o B, se identifica con el conjunto de todos aquellos enunciados que se siguen de ella.

.

.

Esta definición era muy coherente con la metodología falsacionista que defendía Popper, por dos razones: en primer lugar, el falsacionismo nos sugiere preferir aquellas teorías que tengan menos refutaciones y más corroboraciones, aunque al tener algunas refutaciones sean, por lo tanto, falsas; la definición de Popper viene a ser equivalente a decir que una teoría es más verosímil que otra si y sólo si, una vez conocidos todos los hechos, el conjunto de hechos que refutan a la primera teoría es un subconjunto del conjunto de hechos que refutan a la segunda, y el conjunto de hechos que corroboran a la segunda es un subconjunto del conjunto de hechos que corroboran a la primera.

.

Y en segundo lugar, algo más sutil: SI la verdad fuese que A es más verosímil que B en el sentido de Popper, de ahí se seguiría que todos los enunciados que sabemos que son verdaderos y refutan a A, también refutan a B, y todos los enunciados que sabemos que son verdaderos y corroboran a B, también corroboran a A. Por lo tanto, que A esté menos refutada y más corroborada que B, aunque tanto A y B estén refutadas, es una predicción que se sigue de la hipótesis de que A es más verosímil que B. Y por lo tanto, si esa predicción se cumple, habremos corroborado esta hipótesis. El método científico falsacionista se podría entender, por lo tanto, no como el intento de corroborar o refutar teorías "aisladas", sino como el intento de corroborar o refutar hipótesis del tipo "A es más verosímil que B" (algo que posteriormente explotaría Imre Lakatos al insistir en que la contrastación empírica de teorías siempre es comparativa: lo que hacemos es siempre juzgar de entre dos o más teorías cuál tiene más éxito en comparación con las demás).

.

.

Por desgracia para Popper, poco tiempo después se mostró (por parte de Pavel Tichy) que esta definición era inadecuada, pues tenía la desafortunada consecuencia de que, según ella, dos teorías falsas cualesquiera no podían encontrarse en ningún caso en la relación establecida por la definición, es decir, no podía ocurrir que una teoría falsa fuese más verosímil que otra teoría falsa. O más en general: una teoría falsa no puede ser más verosímil que otra teoría, independientemente de si la segunda es verdadera o falsa. Veámoslo:

.

Sea A una teoría falsa; eso quiere decir que hay al menos un enunciado falso, C, que se sigue de A. Si A es más verosímil que B, eso implica (por la definición de Popper) que hay al menos un enunciado verdadero, D, que se sigue de A pero no de B. Por tanto, el enunciado C&D también se seguirá de A (pues tanto C como D se siguen de A), pero no se sigue de B (porque si se siguiera, entonces D también se seguiría de B, y hemos supuesto que no lo hace). Ahora bien, C&D es un enunciado falso, luego existe al menos un enunciado falso que se sigue de A y no se sigue de B, por lo que A no puede ser más verosímil que B (recuérdese que una de las condiciones de la definición era que, para que A sea más verosímil que B, todos los enunciados falsos que se siguen de A tienen que seguirse de B).

.

Popper reaccionó a esa demostración recogiendo el rabo entre las piernas casi por única vez en su vida, olvidándose de su definición de verosimilitud (en realidad, de sus definiciones, porque había intentado proponer una definición "cuantitativa", que también se demostró inútil), y reclamando la legitimidad de afirmar algo así como que

1) "de dos teorías falsas, una de ellas puede estar más próxima a la verdad que la otra, aunque

2) no tengamos una forma precisa de explicar qué coño quiere decir esto, y

3) el progreso científico consiste en encontrar teorías cada vez más próximas a la verdad.

.

No cabe duda de que esta reacción es poco afortunada y pide a gritos mayores aclaraciones sobre la noción de "teorías falsas más próximas a la verdad que otras", y sobre todo, sobre la conexión de esta noción con los métodos de la ciencia. ¿Alguna sugerencia?

.

.

Más:

.

Progreso científico y aproximación a la verdad (2)

.

Éxito explicativo y credibilidad

.

David Deutsch y la explicación de Fierabrás

.

Empirismo, racionalismo y ciencia

.

Flotando en el cieno

.

La verdad no es un concepto epistémico

.

Verdad y progreso empírico

.

¿De qué están hechos los hechos?

.

Epistemología y agencias de rating

.

Falibilismo

.

Cometer errores

.

.

Sabemos, al menos desde Karl Popper, que el progreso científico no consiste, al menos no meramente, en una "acumulación de verdades", sino más bien en la sustitución de unas teorías por otras, cuando las primeras son refutadas por nuevos descubrimientos empíricos. Parece que el destino de todas o casi todas las teorías científicas "importantes" es el de acabar siendo descartadas y reemplazadas por otras teorías "mejores". La cuestión es que Popper era un filósofo realista: pensaba que el objetivo de la ciencia es la verdad, y que precisamente la razón para abandonar una teoría refutada era que la refutación equivalía a mostrar que la teoría era falsa. Pero, si todas las teorías científicas "serias" serán tarde o temprano refutadas, eso significa que todas esas teorías son, en el fondo, falsas... ¿y qué ganamos entonces al sustituir una teoría que hemos mostrado que es falsa por otra teoría que resulta que es falsa también? Nótese que para un instrumentalista esto no es un problema: las teorías "nuevas" pueden ser "mejores" en el sentido de que nos permiten calcular predicciones más exactas, p.ej., y no importa si las teorías mismas sean falsas; pero, como digo, Popper era realista, no consideraba que lo que hace que una teoría sea mejor o peor consista sólo en que sus predicciones son mejores.

.

Para responder a esta cuestión, Popper propuso el concepto de verosimilitud: dos teorías falsas pueden diferenciarse en que una de ellas está "más próxima a la verdad" que la otra. El objetivo de la ciencia para un realista podría consistir, pues, en encontrar teorías que estén "cada vez más próximas a la verdad", que sean cada vez más "verosímiles" (en este sentido especial).

.

Popper sugirió una definición más técnica del concepto de verosimilitud: la teoría A es más verosímil que la teoría B si (y sólo si) todas las consecuencias verdaderas de B son consecuencias de A, y todas las consecuencias falsas de A son consecuencias de B, y además A tiene alguna consecuencia verdadera que no tiene B, o B alguna consecuencia falsa que no tiene A. Dicho de otro modo: A es más verosímil que B si (y sólo si) A tiene todos los "aciertos" de B y B tiene todos los "fallos" de A. La imagen siguiente muestra esa relación, donde cada teoría, A o B, se identifica con el conjunto de todos aquellos enunciados que se siguen de ella.

.

.

Esta definición era muy coherente con la metodología falsacionista que defendía Popper, por dos razones: en primer lugar, el falsacionismo nos sugiere preferir aquellas teorías que tengan menos refutaciones y más corroboraciones, aunque al tener algunas refutaciones sean, por lo tanto, falsas; la definición de Popper viene a ser equivalente a decir que una teoría es más verosímil que otra si y sólo si, una vez conocidos todos los hechos, el conjunto de hechos que refutan a la primera teoría es un subconjunto del conjunto de hechos que refutan a la segunda, y el conjunto de hechos que corroboran a la segunda es un subconjunto del conjunto de hechos que corroboran a la primera.

.

Y en segundo lugar, algo más sutil: SI la verdad fuese que A es más verosímil que B en el sentido de Popper, de ahí se seguiría que todos los enunciados que sabemos que son verdaderos y refutan a A, también refutan a B, y todos los enunciados que sabemos que son verdaderos y corroboran a B, también corroboran a A. Por lo tanto, que A esté menos refutada y más corroborada que B, aunque tanto A y B estén refutadas, es una predicción que se sigue de la hipótesis de que A es más verosímil que B. Y por lo tanto, si esa predicción se cumple, habremos corroborado esta hipótesis. El método científico falsacionista se podría entender, por lo tanto, no como el intento de corroborar o refutar teorías "aisladas", sino como el intento de corroborar o refutar hipótesis del tipo "A es más verosímil que B" (algo que posteriormente explotaría Imre Lakatos al insistir en que la contrastación empírica de teorías siempre es comparativa: lo que hacemos es siempre juzgar de entre dos o más teorías cuál tiene más éxito en comparación con las demás).

.

.Por desgracia para Popper, poco tiempo después se mostró (por parte de Pavel Tichy) que esta definición era inadecuada, pues tenía la desafortunada consecuencia de que, según ella, dos teorías falsas cualesquiera no podían encontrarse en ningún caso en la relación establecida por la definición, es decir, no podía ocurrir que una teoría falsa fuese más verosímil que otra teoría falsa. O más en general: una teoría falsa no puede ser más verosímil que otra teoría, independientemente de si la segunda es verdadera o falsa. Veámoslo:

.

Sea A una teoría falsa; eso quiere decir que hay al menos un enunciado falso, C, que se sigue de A. Si A es más verosímil que B, eso implica (por la definición de Popper) que hay al menos un enunciado verdadero, D, que se sigue de A pero no de B. Por tanto, el enunciado C&D también se seguirá de A (pues tanto C como D se siguen de A), pero no se sigue de B (porque si se siguiera, entonces D también se seguiría de B, y hemos supuesto que no lo hace). Ahora bien, C&D es un enunciado falso, luego existe al menos un enunciado falso que se sigue de A y no se sigue de B, por lo que A no puede ser más verosímil que B (recuérdese que una de las condiciones de la definición era que, para que A sea más verosímil que B, todos los enunciados falsos que se siguen de A tienen que seguirse de B).

.

Popper reaccionó a esa demostración recogiendo el rabo entre las piernas casi por única vez en su vida, olvidándose de su definición de verosimilitud (en realidad, de sus definiciones, porque había intentado proponer una definición "cuantitativa", que también se demostró inútil), y reclamando la legitimidad de afirmar algo así como que

1) "de dos teorías falsas, una de ellas puede estar más próxima a la verdad que la otra, aunque

2) no tengamos una forma precisa de explicar qué coño quiere decir esto, y

3) el progreso científico consiste en encontrar teorías cada vez más próximas a la verdad.

.